Datenbasierte Prozesse und Automatisierung,

Kreislaufwirtschaft und Ressourceneffizienz

Hier wird die Müllabfuhr im Weltraum simuliert

Im Labor des Kompetenzzentrum Intelligent Sensors and Networks an der HSLU – T&A trainieren Forschende eine Kamera mit KI-Modellen, damit sie künftig im Weltraum eingesetzt werden kann. Das Ziel: gefährlichen Schrott im All entfernen.

Viele Jahrzehnte wurde dem Thema Nachhaltigkeit in der Raumfahrt wenig Beachtung geschenkt. Heute befinden sich daher zigtausende ausgediente Satelliten sowie Trümmerteile aus Explosionen und Kollisionen in erdnahen Umlaufbahnen. Ohne die aktive Entfernung der grössten Teile dieses Weltraummülls sind künftige Raumfahrtmissionen ernsthaft gefährdet.

Kreislaufwirtschaft im Weltall

Umweltschutz und Kreislaufwirtschaft sind nicht mehr nur auf der Erde zentrale Themen. Längst beziehen die Bemühungen für eine nachhaltige Entwicklung auch das Weltall ein. Die aktive Entsorgung von Weltraumschrott aus dichtbesiedelten Umlaufbahnen, spielt dabei eine wichtige Rolle. Siehe auch:

Tüfteln für die Müllabfuhr im Weltall

Im Rahmen der ESA Clean Space Initiative wird am CC ISN in Kooperation mit Sirin Orbital Systems AG eine intelligente Weltraumkamera entwickelt. Die Idee:

- Mit einem Bildsensor soll die Kamera Bilddaten des anzusteuernden Objektes aufnehmen.

- Daraus werden mit Hilfe von KI-Modellen die Position und Lage des Objektes relativ zum Jägersatelliten ermittelt.

- Die Steuereinheit des Jägersatelliten nutzt diese Informationen dann, um sich dem Zielobjekt selbständig und sicher zu nähern.

Test von Weltraumtechnologie im HSLU-Labor

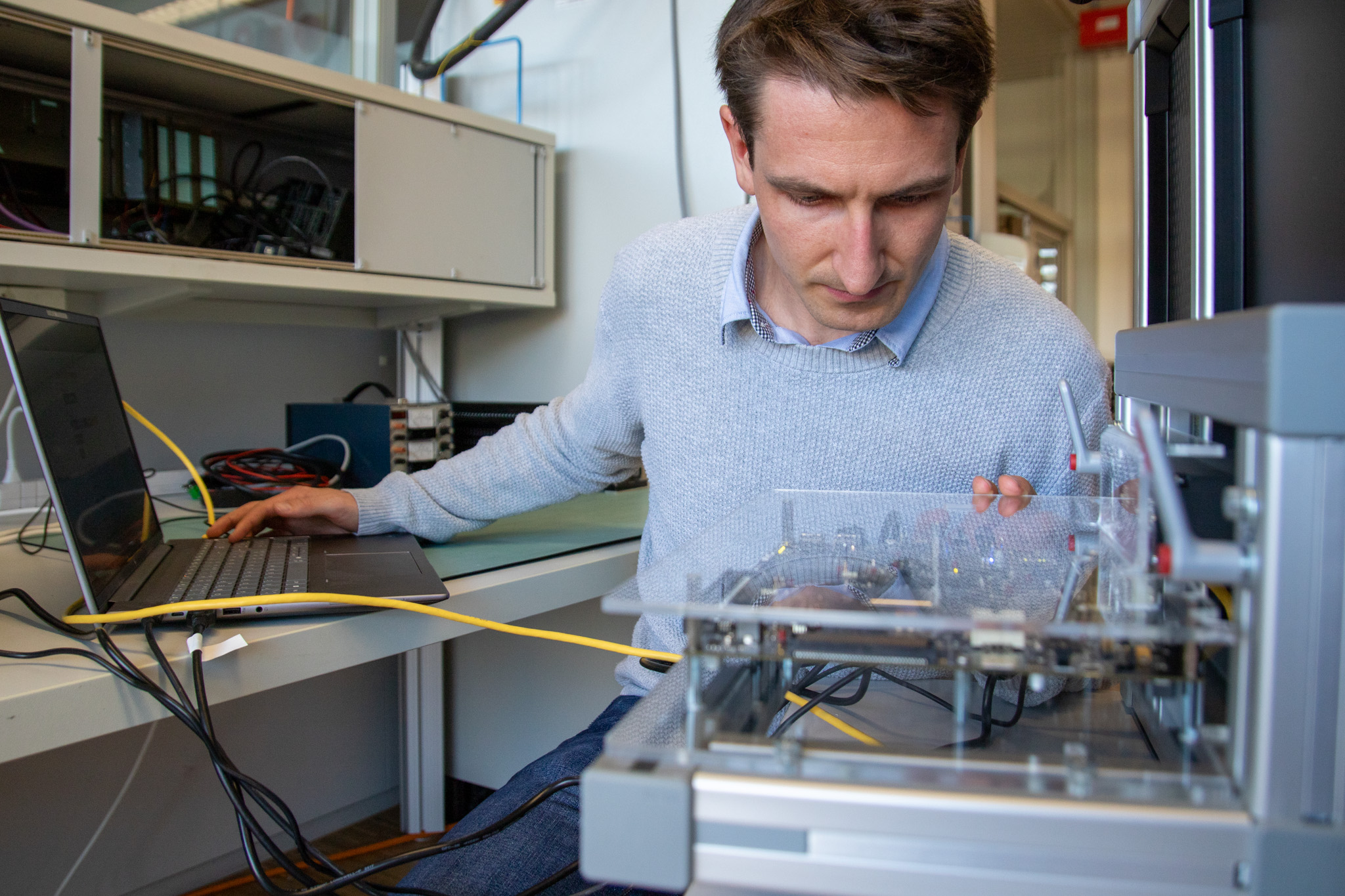

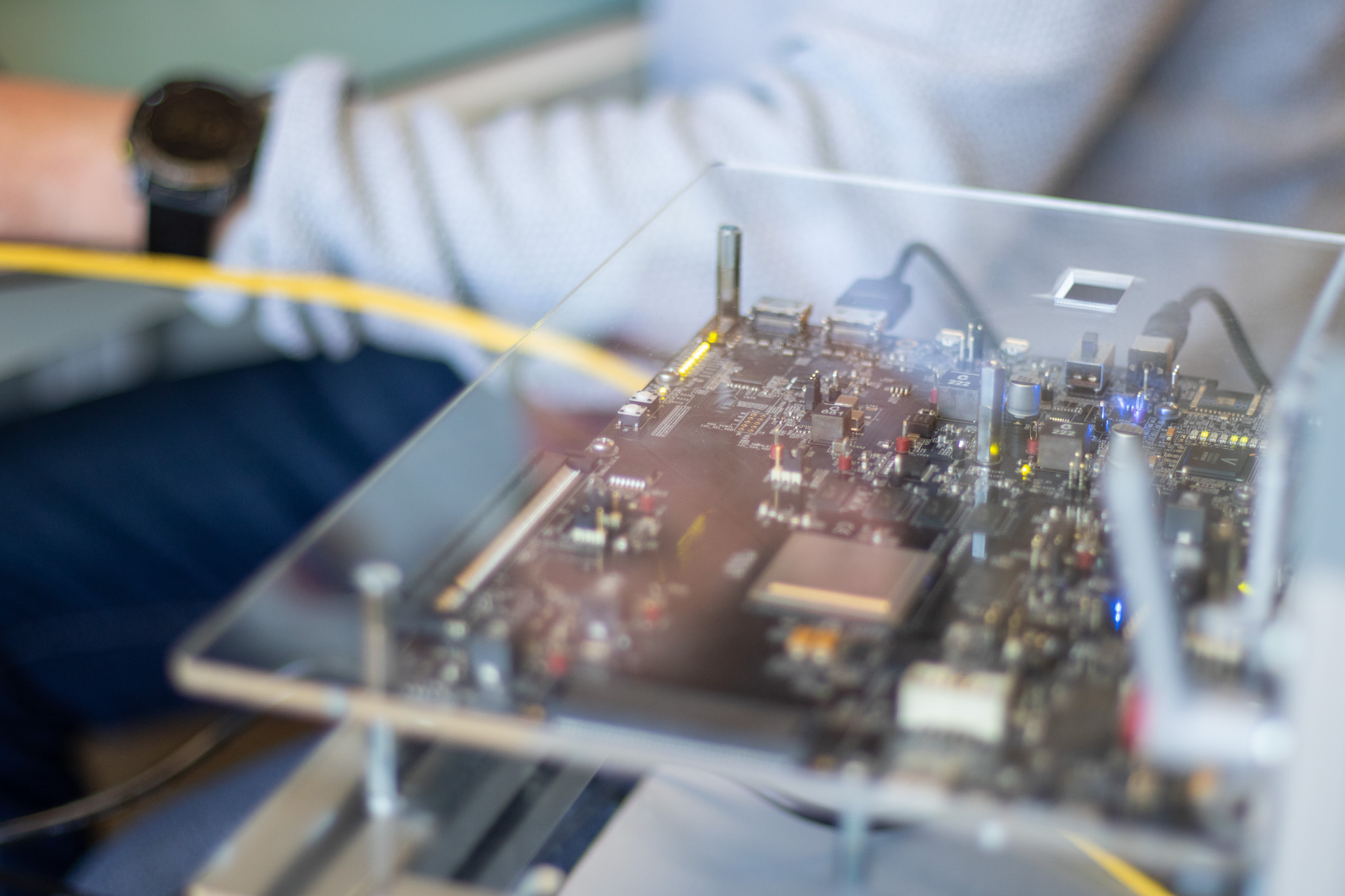

Vor kurzem ist es den Forschenden gelungen, einen ersten Prototyp der Kamera auf einer weltraum-tauglichen Hardware-Plattform zu realisieren, einem sog. FPGA (Field Programmable Gate Array) System-on-Chip, der speziell für die harten Einsatzbedingungen im Weltall ausgelegt ist. Dabei half dem Team um Forschungsgruppenleiter Jürgen Wassner die langjährige Erfahrung mit der Entwicklung von FPGA-Lösungen für anspruchsvolle Signalverarbeitungsaufgaben, wie z.B. der Powerline Train Backbone Technologie für den digitalen Güterzug.

Aber schon sehr bald stellte sich die Frage: Wie testet man die Kamera vor dem Einsatz im Weltall? Reale Bilder aus dem All gibt es viel zu wenig, um die KI-Modelle zuverlässig trainieren zu können. Und wie stellt man die Bewegung von Zielobjekt und Jägersatellit in ihrem Orbit um die Erde im Labor nach?

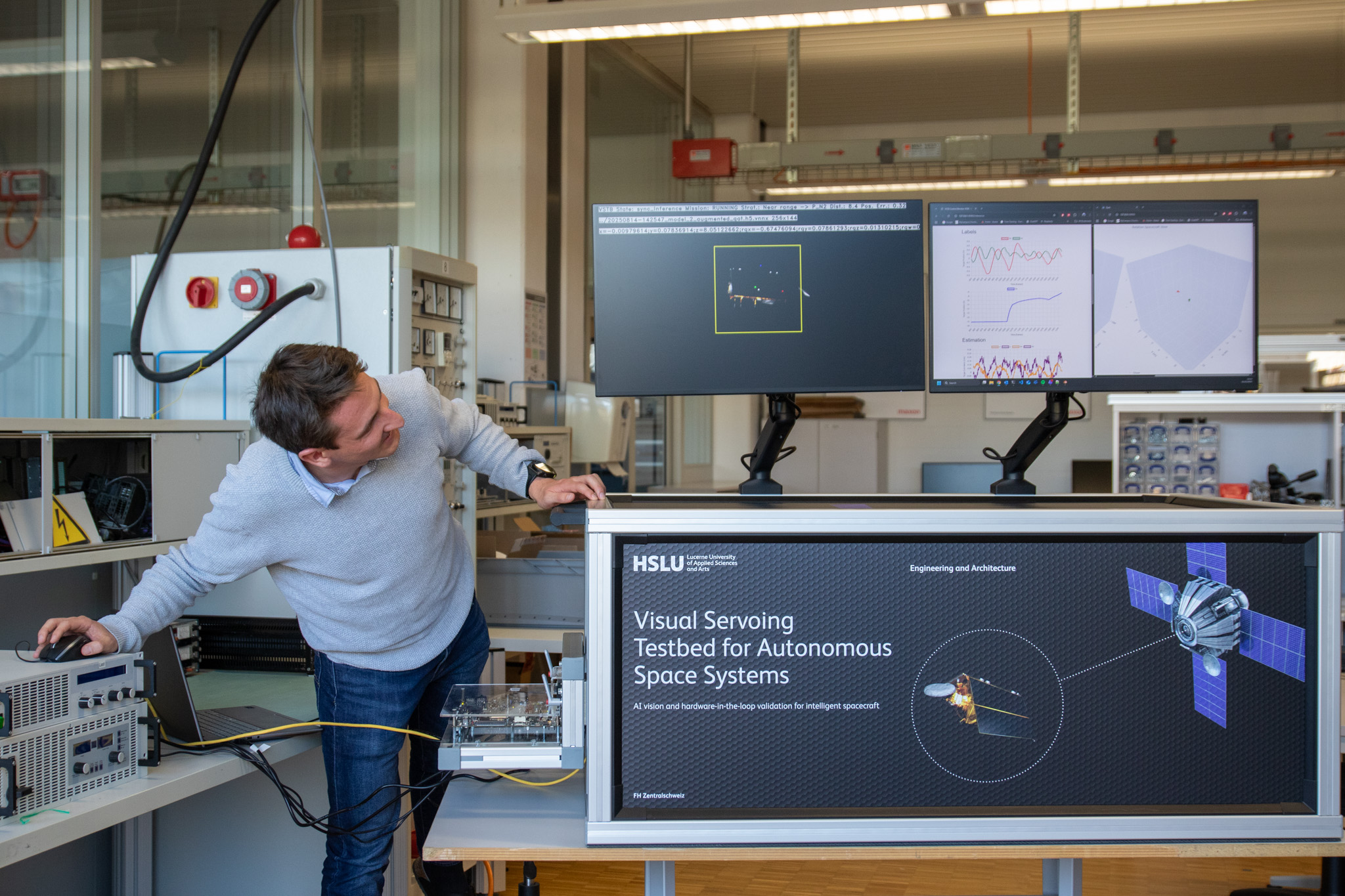

So funktioniert das Visual Servoing Testbed

In einem vom SBFI geförderten Projekt haben die Forschenden deshalb eigens eine Testumgebung entwickelt, die speziell auf diese Herausforderungen ausgerichtet ist.

- Der Teststand funktioniert rein visuell und kommt ganz ohne bewegliche Teile aus.

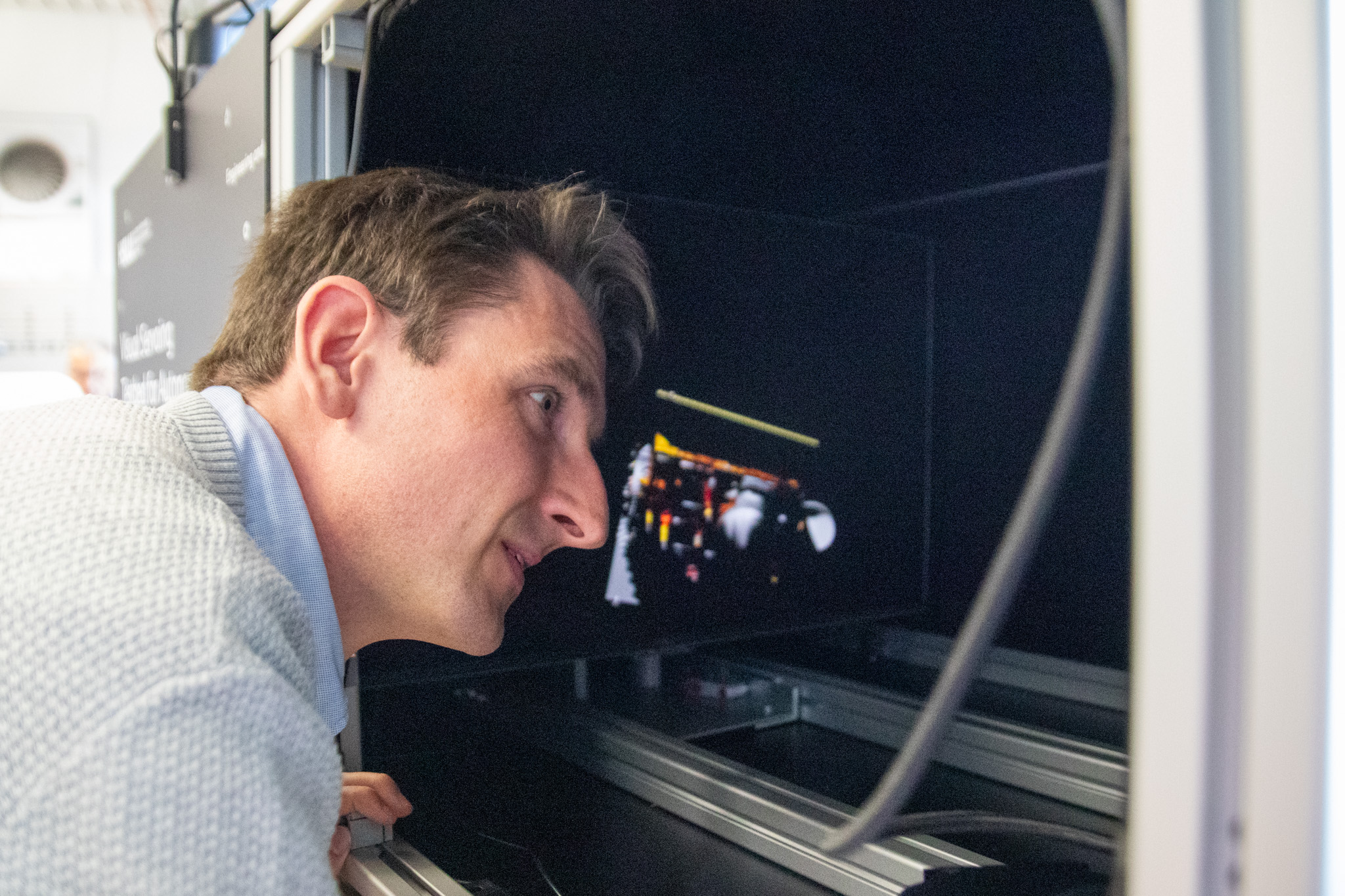

- Künstlich generierte Bilder stellen die Situation im All detailgetreu nach,

- und astro-dynamische Modelle sorgen dafür, dass sich die Objekte in den generierten Bildern so bewegen wie später im All.

Auf diese Weise ermöglicht die Testumgebung nicht nur die Erzeugung beliebig vieler und qualitativ hochwertiger Trainingsdaten für die KI-Modelle der Kamera. In einer anderen Betriebsart wird die Kamera selbst realitätsnah getestet. Dafür werden die trainierten KI-Modelle auf der FPGA SoC Plattform in einer sog. Camera-in-the-Loop Simulation ausgeführt. Diese Tests zeigen, wie gut das gesamte Kamerasystem, inklusives des Bildsensors, im Echtzeitbetrieb wirklich funktioniert.

Visuell oder Mechanisch oder beides?

Einen ganz anderen Testansatz verfolgt man z.B. am ESA Testlabor GRALS (Guidance Navigation and Control Rendezvous, Approach and Landing Simulator). Dort setzt man auf Satellitenmodelle, sog. Mockups, die von Roboterhand geführt die Bewegung im Weltall nachvollziehen. Die Mockups sollen dabei in Form und Aussehen den realen Objekten im Weltraum möglichst ähnlich sein.

Noch ist ungeklärt, was der richtige Ansatz ist. Am Ende könnte es gut sein, dass beide Testverfahren nötig sind, um Technologien für die bildgestützten Navigation im Weltall zuverlässig im Labor zu testen. Damit das Team des CC ISN seine Expertise aktiv in die internationale Diskussion zu diesem Thema einbringen kann, unterstützt die Stiftung zur Förderung der HSLU T&A gezielt die Aktivitäten der Forscher:innen.

Das menschliche Sehsystem als Vorbild einer energiesparenden Kamera

Aber nicht nur der Test der Kamera bereitet den Forschenden Kopfzerbrechen. Eine weitere Herausforderung ergibt sich aus dem sehr beschränkten Energiebudget an Board des Jägersatelliten. Deshalb muss der Energiehunger der KI-Modelle der Kamera gezügelt werden.

Inspiration bietet dem Team des CC ISN dabei das menschliche Sehsystem. Im menschlichen Auge werden die Signale von ca. 100 Millionen Fotorezeptoren auf ca. 1 Million Nervenfasern im Sehnerv komprimiert und in Form von elektrochemischen Impulsen zum Gehirn transportiert. Dort entsteht aus diesen Impulsen ein Gesamtbild der Umgebung.

Ermöglicht durch eine grosszügige Spende der Adrian-Weiss Stiftung an die HSLU Foundation, kann das Team jetzt einen neuartigen Bildsensor erproben, der sich das Prinzip des menschlichen Sehens zu eigen macht. Durch Kombination mit einer speziellen Art von KI-Modellen, sog. Spiking Neural Networks, erhoffen sich die Forschenden den Energieverbrauch ihrer Weltraum-Kamera weiter reduzieren zu können.

Jetzt soll die Weltraumkamera das nächste Level erreichen

Nach dem Abschluss des aktuellen Projektes sollen sowohl die visuelle Testumgebung als auch ein Prototyp der Weltraum-Kamera vorliegen. Danach ist für das Team die Arbeit aber noch lange nicht getan. Vielmehr beginnt eine neue Phase, in der die Weltraumkamera durch einen anforderungs-basierten Entwicklungsprozess auf ein höheres TRL (Technology Readiness Level) gebracht werden soll.

Technology Readiness Level (TRL)

Ursprünglich im Jahr 1974 von der NASA konzipiert, dient das heutige neunstufige TRL-System als Massstab für die technische Reife einer Technologie und wird mittlerweile nicht nur in der Raumfahrt, sondern auch in vielen weiteren Bereichen mit hohen Sicherheitsstandards, etwa in der Avionik, der Bahn- und Medizintechnik eingesetzt. Eine eher intuitive Erklärung der neun Stufen des TRL bedient sich eines Vergleichs mit einem Einhorn: https://www.granttremblay.com/blog/trls

Und so werden die Forschenden neben der künstlichen auch ihre eigne Intelligenz weiterhin gut gebrauchen können, um einen Beitrag zur nachhaltigen Entwicklung im Weltall zu leisten.

Kommentare

0 Kommentare

Danke für Ihren Kommentar, wir prüfen dies gerne.