Kausalität statt Korrelation – Ein Paradigmenwechsel im Machine Learning

Künstliche Intelligenz wirkt oft so, als wüsste sie genau, was zu tun ist. In Wahrheit basiert ihr aktuelles Können weitgehend auf dem Erkennen und Ausnutzen von Korrelationen in Mustern – und das ziemlich gut. Doch Korrelationen sind keine Kausalitäten und geben kein echtes Verständnis für die Konsequenzen oder den potentiellen Wert von Aktionen. Ohne echtes Verständnis für Ursache und Wirkung und ohne die Fähigkeit, den Wert von Handlungen zu antizipieren, bleibt auch die klügste Maschine oder die beste «Agentic AI» ein stochastischer Papagei. Doch wie bringt man diese Aspekte Algorithmen bei? Dies wurde vorletzte Woche an der CLeaR-Konferenz in Lausanne diskutiert.

Künstliche Intelligenz kann vieles: Sie sagt Wahrscheinlichkeiten voraus, schlägt uns beim Online-Shopping Produkte vor, von denen wir selbst noch nicht wussten, dass wir sie brauchen oder generiert imponierende Texte und Bilder. Doch so sehr uns diese Systeme auch beeindrucken mögen – sie bleiben oftmals an der Oberfläche. Denn während sie statistisch elegant Zahlen jonglieren, verstehen sie oft den Wert von Handlungen nicht, sprich warum etwas passiert oder was passieren würde, wenn man anders handelt.

Dieser Perspektivwechsel stand vom 07. bis 09.Mai im Zentrum der Causal Learning and Reasoning (CLeaR) Konferenz in Lausanne. Forschende aus aller Welt trafen sich, um über methodische Fortschritte im Bereich der kausalen Inferenz zu diskutieren – einem Feld, das versucht, Algorithmen nicht nur beobachten zu lassen, sondern sie zu einem Verständnis für Handlungen und deren Konsequenzen zu führen.

Was genau ist kausale Inferenz?

Kausale Inferenz beschäftigt sich mit der Frage, ob ein beobachteter Zusammenhang zwischen zwei Phänomenen auf einem kausalen Beziehung beruht – also das eine das andere verursacht – oder ob es sich lediglich um eine Korrelation handelt. Dieser Unterschied mag auf den ersten Blick subtil erscheinen, ist aber von fundamentaler Bedeutung.

Ein oft zitiertes Beispiel veranschaulicht dies: In Zeiten, in denen mehr Glaces gegessen werden, gibt es auch mehr Ertrinkungsunfälle. Bedeutet das, dass das Glace Menschen ins Wasser treibt? Natürlich nicht. Die zugrundeliegende gemeinsame Variable ist das Wetter: An heissen Tagen gehen mehr Menschen schwimmen und essen mehr Glace. Eine Korrelation liegt vor – aber keine Kausalität.

Nicht immer ist die gemeinsame Ursache so offensichtlich wie das Wetter.

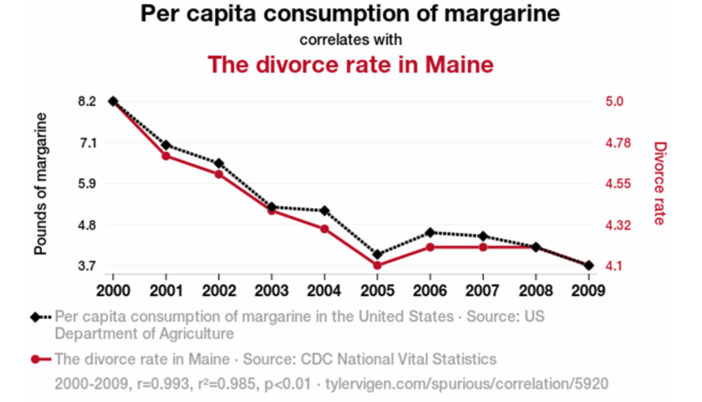

In einem skurrilen Beispiel korrelierte in bestimmten US-Staaten über Jahre hinweg der Pro-Kopf-Konsum von Margarine erstaunlich gut mit der Scheidungsrate. Das heisst aber natürlich nicht, dass zu viel Streichfett die Ehe ruiniert – würde man die Scheidungsrate reduzieren wollen, so würde es nichts bringen, den Margarinekonsum zu verbieten. Viel logischer ist, dass eine dritte, versteckte Einflussgrösse – ein sogenannter Confounder – beide Entwicklungen gleichzeitig beeinflusst hat: etwa sozioökonomische Veränderungen, Lebensstil oder kulturelle Trends über die Zeit.

Gerade diese versteckten Einflussfaktoren stellen das Hauptproblem dar, wenn wir aus Korrelationen vorschnell auf Ursachen schliessen wollen. Hier setzt die kausale Inferenz an und versucht, solche Confounders sichtbar zu machen, ihren Einfluss zu kontrollieren – und so echte Kausalzusammenhänge herauszufiltern.

Von Korrelation zu Kausalität: Ein Paradigmenwechsel im ML

Im traditionellen maschinellen Lernen (ML) liegt der Fokus auf Vorhersagen basierend auf den Korrelationen in den beobachteten Daten. Diese ML-Systeme können dabei genau sein, wenn es darum geht zu sagen: «Wenn A auftritt, folgt häufig B» – was häufig dazu verleitet, ML als Entscheidungsgrundlage zu verwenden. Was in solchen Systemen jedoch häufig fehlt, ist das Verständnis von «Einflussnahme», also die Beantwortung der Frage, was mit B passiert, wenn wir aktiv in das System eingreifen und A verändern. Denn um fundiert entscheiden zu können, wieviel beispielsweise in einen Marketing-Kanal investiert werden soll, reicht es nicht, Korrelationen zu sehen – man muss den kausalen Effekt verstehen.

Um ML dahin zu bringen, bedarf es die Integration und Beantwortung von zwei grundlegenden Fragen:

- Interventionsfrage: «Wenn wir A herbeiführen oder ändern, was passiert dann kausal mit B?»

- Kontrafaktische Frage: «Was wäre mit B passiert, hätten wir anders gehandelt oder A nicht herbeigeführt?»

Diese Fragen markieren den Übergang von der reinen Mustererkennung hin zum kausalen Denken – und genau hier kommt die sogenannte Pearl Ladder of Causation ins Spiel.

In fünf Schritten auf die oberste Sprosse der Pearl Ladder of Causation

In seiner Keynote argumentierte Elias Bareinboim, dass viele der heutigen Probleme in der KI – von mangelnder Erklärbarkeit bis hin zu unfairen Entscheidungen – auf ein zentrales Defizit zurückgehen: Die meisten Systeme operieren durchgehend auf einem zu niedrigen Niveau des kausalen Denkens in der Pearl Ladder of Causation. Die Pearl Ladder of Causation, geformt durch den Informatiker Judea Pearl, unterscheidet drei Ebenen des Wissens:

- Assoziationen (Beobachten, was passiert): Die einfachste Form des Lernens, basierend auf statistischen Zusammenhängen und Korrelationen.

- Interventionen (Verstehen, was eine Aktion auslöst): Die Fähigkeit zu verstehen, wie Eingriffe in ein System dessen Verhalten verändern.

- Kontrafaktisches Denken («Was wäre passiert, wenn…»): Die Form des kausalen Verständnisses, die es ermöglicht, alternative Szenarien zu bewerten.

Die meisten aktuellen ML-Systeme operieren hauptsächlich auf der ersten Ebene. Um jedoch robuste und vertrauenswürdige Systeme zu entwickeln, die komplexe Entscheidungen unterstützen können, braucht es die Entwicklung von Methoden, die auch die höheren Ebenen der kausalen Hierarchie erfassen. Gemäss Bareinboim kann dies über eine Roadmap von fünf Schritten erreicht werden:

- Kausales Verständnis: Kausale Strukturen in Daten erkennen – etwa durch Analyse von Abhängigkeiten, Beziehungen und Verteilungen.

- Effizientes Entscheiden: Es braucht Verfahren, die aktiv Entscheidungen austesten, eigene Lernwege entdecken und sich nicht an bestehenden Mustern orientieren – etwa durch die Integration von Methoden wie Reinforcement Learning.

- Robuste Generalisierung: Erkenntnisse müssen auf neue Umgebungen übertragbar gemacht werden – etwa durch Transportierbarkeit, Domain Adaptation oder die Generalisierung kontrafaktischer Aussagen.

- Kausales Generieren: Es gilt, generative Modelle mit kausalen Repräsentationen, kontrafaktischen Bildverteilungen und abstrakten Strukturkonzepten auszustatten – für kontrollierbares und erklärbares Generieren.

- Lernen kausaler Strukturen: Um Ursache-Wirkungs-Strukturen zuverlässig zu erfassen, braucht es Fortschritte im strukturellen Lernen (Kombination von Beobachtungs- und RCT-Studien), im multi-domänenbasierten Strukturlernen (für übergreifende Invarianzen), und im kausalen Repräsentationslernen.

Sounds fancy – but does it work in practice?

Auch wenn das Feld der kausalen Inferenz noch stark forschungsgetrieben ist, zeigen erste Entwicklungen bereits, wie sich diese Prinzipien praktisch umsetzen lassen. Auf der Konferenz wurden mehrere spannende Ansätze vorgestellt, die zeigen, dass Kausalität nicht nur Subjekt für philosophische Diskussionen, sondern ein gangbarer Weg in der Welt der Algorithmen ist.

Eine der Präsentationen befasste sich mit einem neuartigen Ansatz zur kontrafaktischen Analyse von Large Language Models (LLMs). Das vorgestellte Verfahren ermöglicht die Evaluation, wie ein LLM auf einen leicht veränderten Prompt reagiert hätte. Das ist bedeutsam, weil LLMs zwar Kontext aus einem vorherigen Prompt berücksichtigen können, aber kein echtes Gedächtnis oder Verständnis für ihren eigenen Entscheidungsprozess besitzen. Sie können nicht erklären, warum sie eine bestimmte Antwort gewählt haben, wie sie diese replizieren könnten – und schon gar nicht, was passiert wäre, wenn der Input leicht anders gewesen wäre. Mit dem vorgestellten Analyseverfahren lässt sich dies approximieren und eröffnet somit neue Wege für Erklärbarkeit und bessere Kontrolle solcher Modelle.

Der Beitrag von David Blei stellte Hierarchical Causal Models vor – eine Erweiterung klassischer Kausalgraphen, die mit verschachtelten Daten umgehen kann, z. B. Schüler:innen in Schulen oder Zellen in Patienten.

Statt nur auf Aggregatwerte wie den Durchschnitt zu schauen, modelliert dieser Ansatz Beziehungen innerhalb und zwischen Gruppen. Damit lassen sich kausale Effekte identifizieren, die in klassisch zusammengefassten Daten verborgen bleiben – etwa, wie eine Schulpolitik individuell auf Schüler:innen wirkt.

Von der Vorhersage zur Verantwortung: Warum KI kausales Denken lernen muss

Maschinelles Lernen hat uns beeindruckende Werkzeuge in die Hand gegeben – doch um wirklich fundierte, faire und erklärbare Entscheidungen zu ermöglichen, reicht das blosse Erkennen von Mustern nicht aus. Die CLeaR-Konferenz hat deutlich gemacht: Die Zukunft der KI liegt im kausalen Verstehen. Nur wenn Systeme lernen, zwischen Ursache und Korrelation zu unterscheiden, Interventionen zu beurteilen und kontrafaktische Alternativen zu analysieren, können sie zu echten Entscheidungspartnern werden. Die vorgestellten Methoden und Modelle zeigen: Der Weg dorthin ist komplex, aber möglich – mit vielversprechenden Ansätzen und einer klaren Roadmap. Künstliche Intelligenz muss nicht nur lernen, was ist – sondern auch begreifen, was sein könnte.

Das Marketing steht vor komplexen Entscheidungen, in denen Interventionen und Ursache-Wirkung eine zentrale Rolle spielen: Welchen Kunden soll man mit welcher Botschaft ansprechen – wen lass ich besser in Ruhe? Und wieviel Geld soll man in welchen Online-Channel eigentlich investieren, so dass das investierte Geld ein Maximum an Kundschaft erreicht?

Finden Sie sich in solchen oder ähnlichen Fragestellungen wieder? Wir forschen daran. Lassen Sie uns wissen, wie wir Sie unterstützen können – melden Sie sich bei uns.

Kommentare

0 Kommentare

Danke für Ihren Kommentar, wir prüfen dies gerne.