16. Februar 2026

Mit Sicherheit unsicher

Evaluations sind ein zentraler Bestandteil beim Einsatz von AI in der Immobilienwirtschaft. Sie zeigen, ob Systeme grundsätzlich funktionieren, garantieren aber keine Verlässlichkeit im operativen Alltag. Gerade bei kontextsensitiven und zunehmend agentischen AI-Systemen bleiben menschliche Verantwortung, Nachvollziehbarkeit und klare Governance unverzichtbar. Dieser Blog plädiert für einen professionellen Umgang mit dieser Unsicherheit.

Ein Artikel von: Dr. Mark Gille-Sepehri und Prof. Dr. Markus Schmidiger

Warum AI-Systeme in der Immobilienwirtschaft geprüft werden müssen – und warum das allein nicht reicht

78 % aller Organisationen nutzen AI inzwischen in mindestens einer Geschäftsfunktion – ein deutlicher Sprung gegenüber 55 % im Vorjahr, was zeigt, wie schnell AI vom Experiment zur operativen Realität wird (netguru).

Künstliche Intelligenz geniesst in der Immobilienwirtschaft keinen Vertrauensvorschuss. Im Gegenteil: Viele Nutzer haben bereits erlebt, dass AI-Systeme überzeugend formulieren – und dabei schlicht falsch liegen. Forschung beschreibt dieses Phänomen als „Halluzination“: plausibel klingende, aber nicht-faktische Inhalte, die gerade in realen Informations- und Entscheidungsprozessen problematisch werden können.

Begriffe wie „Halluzinationen“ sind längst kein Fachjargon mehr, sondern Teil der Alltagserfahrung. Entsprechend gross ist die Skepsis – besonders dann, wenn AI nicht nur eine spontane Ad-hoc-Frage beantworten soll, sondern Kernprozesse der Immobilienwirtschaft betrifft: Investitionsentscheidungen, Bewertungen, Mieterkommunikation, Instandhaltungsplanung oder Budgetierung (Ji et al., 2023; Bender et al., 2021).

Unternehmen nutzen zunehmend generative Modelle (z. B. für Content, Analysen, Assistenz), doch 77 % der Unternehmen geben an, sich wegen Halluzinationen Sorgen zu machen – also wegen unzuverlässigen, erfundenen Antworten, die Vertrauen und Sicherheit untergraben können (fullview.io).

Studien dokumentieren, dass grosse Sprachmodelle bei komplexen fachlichen Aufgaben in 58 % bis 82 % der Fälle Halluzinationen zeigen, wenn sie z. B. juristische Aussagen oder Fakten generieren (hai.standford.edu).

Diese Skepsis ist berechtigt. Denn selbst wenn ein AI-System getestet, geprüft und mehrfach erfolgreich erprobt wurde, bleibt eine unbequeme Wahrheit: Man kann es zehn, fünfzig oder hundert Mal testen – und trotzdem kann es beim 101. Mal nicht funktionieren (Bommasani et al., 2022; NIST, 2023).

Die entscheidende Frage lautet daher nicht: „Haben wir ausreichend getestet?“

Sondern: „Wie gehen wir damit um, dass es trotz Tests scheitern kann?“

Genau diese Perspektive – Risiko statt Bauchgefühl – steht auch im Mittelpunkt moderner AI-Risikorahmenwerke.

Warum AI sich trotz Tests unterschiedlich verhalten kann

Auf den ersten Blick wirkt es widersprüchlich: Theoretisch lassen sich AI-Sprachmodelle so konfigurieren, dass sie bei exakt gleichen Eingaben immer dieselbe Antwort liefern.

In der Praxis ist das jedoch selten relevant. AI-Systeme reagieren sehr sensibel auf Kontext – auf Formulierungen, auf zusätzliche oder fehlende Informationen und auf den jeweiligen Nutzungskontext. Schon kleine Unterschiede, die im Alltag unvermeidlich sind, können zu anderen Ergebnissen führen. Nicht, weil das System „zufällig“ arbeitet, sondern weil es Zusammenhänge bewertet und unterschiedlich gewichtet (Bommasani et al., 2022; Ji et al., 2023).

Deshalb kann ein AI-System in vielen Tests zuverlässig funktionieren – und im nächsten Moment zu einer anderen, unerwarteten Einschätzung kommen. Für Unternehmensprozesse bedeutet das: Tests sind notwendig, aber sie können nicht jede reale Situation vorwegnehmen. Absolute Verlässlichkeit lässt sich nicht vollständig „herausprüfen“.

Was bedeutet „Evaluation“ im Alltag der Immobilienwirtschaft?

„Evaluation“ heisst schlicht: man prüft, ob ein AI-System im vorgesehenen Rahmen sinnvoll funktioniert. Das kann heissen: Wie gut beantwortet es Anfragen? Wie plausibel sind Analysen? Wie zuverlässig bleibt es bei wiederkehrenden Aufgaben? Wie schnell war es? Was waren die Kosten (Tokens, Fremdsystem)?

Solche Prüfungen sind wichtig – und in der Forschung gut etabliert, inklusive breiter Benchmark-Ansätze und systematischer Übersichten zu Stärken, Schwächen und blinden Flecken von Tests.

Was Tests aber nicht automatisch leisten: Sie garantieren nicht, dass das System im echten Betrieb (Zeitdruck, unvollständige Daten, neue Marktsituationen, ungeplante Nutzerfragen) genauso gut funktioniert wie im Test. Genau hier entsteht die Lücke zwischen „im Labor gut“ und „im Alltag robust“ (NIST, 2023; Bommasani et al., 2022).

Wenn AI fachlich korrekt klingt – und trotzdem riskant ist

Ein zentrales Risiko moderner AI-Systeme liegt nicht nur in offensichtlichen Fehlern, sondern in plausiblen Vereinfachungen: Ein Ergebnis wirkt stimmig, eine Begründung klingt professionell – aber Annahmen bleiben unklar, Quellen fehlen, Unsicherheiten werden nicht sichtbar (Ji et al., 2023; Bender et al., 2021).

Gerade bei Faktennähe und Wahrhaftigkeit zeigen Benchmarks, wie schnell Modelle „menschliche Irrtümer“ überzeugend nachbilden können – und warum „klingt richtig“ kein Qualitätskriterium ist.

Human in the Loop: Verantwortung bleibt beim Menschen

Gerade deshalb ist das Prinzip des Human in the Loop entscheidend. Gemeint ist nichts Technisches, sondern ein Grundprinzip: Ein Mensch bleibt sichtbar und bewusst Teil jeder relevanten Entscheidung (Amershi et al., 2019; Doshi-Velez & AIm, 2017).

AI kann vorbereiten, strukturieren und Optionen aufzeigen. Aber sie darf Entscheidungen nicht unbemerkt ersetzen – weder bei Investitionen, noch bei Bewertungen, noch in der Kommunikation mit Mietern oder Geschäftspartnern.

In der Praxis ähnelt der Umgang mit AI damit stark der Aussteuerung von Teammitgliedern:

Man gibt Aufgaben vor, formuliert Erwartungen (vergleichbar mit Prompts), prüft Zwischenergebnisse, hinterfragt Annahmen und übernimmt am Ende die Verantwortung für das Resultat.

Der entscheidende Unterschied liegt im Qualitätsanspruch:

Während menschliche Mitarbeiter ermüden, Tippfehler machen oder Informationen übersehen, tut AI all das nicht. Fehler entstehen hier nicht durch Nachlässigkeit, sondern durch falsche Annahmen, unklare Zielvorgaben oder fehlende Kontrolle.

Gerade deshalb muss der Qualitätsstandard bei AI höher sein als bei menschlicher Zuarbeit – nicht niedriger. Human in the Loop bedeutet also nicht, grosszügiger zu sein, sondern konsequenter: klare Erwartungen, systematische Prüfung von Ergebnissen und bewusste Entscheidungspunkte.

Forschung zu Interpretierbarkeit und Erklärbarkeit zeigt genau diesen Zusammenhang: Nur wenn Menschen verstehen, warum ein System zu einer Empfehlung kommt, können sie Ergebnisse verantwortungsvoll einordnen, korrigieren oder übernehmen (Doshi-Velez & AIm, 2017; Amershi et al., 2019).

Audit Trails: Warum Nachvollziehbarkeit unverzichtbar ist

In der Immobilienwirtschaft ist Nachvollziehbarkeit Alltag: Investment Committees, Wirtschaftsprüfer, Aufsichtsgremien und interne Revision stellen regelmässig dieselbe Frage: Wie ist diese Entscheidung zustande gekommen?

Eine grosse Umfrage zeigt: 83 % der Beschäftigten geben an, AI im Unternehmen zu nutzen, aber nur 31 % der Firmen haben eine umfassende AI-Policy – also klare Regeln und Verantwortlichkeiten für Einsatz und Kontrolle (TechRadar).

Für AI-Systeme gilt das genauso. Ein Audit Trail sorgt dafür, dass später nachvollziehbar ist:

- welche Daten verwendet wurden,

- welche Annahmen relevant waren,

- welche Alternativen betrachtet wurden,

- wo menschliche Freigaben erfolgt sind.

Hier helfen etablierte wissenschaftliche Konzepte aus der AI-Governance wie „Model Cards“ (Dokumentation von Zweck, Grenzen, Leistungsprofil) und „Datasheets for Datasets“ (Herkunft, Qualität, Grenzen von Daten). Das sind praktisch Blaupausen dafür, wie man Transparenz und Verantwortbarkeit dokumentiert – und damit Prüf- und Haftungsfähigkeit stärkt (Mitchell et al., 2019; Gebru et al., 2021).

Quellenangaben: Ohne Herkunft kein Vertrauen

Eng damit verbunden sind Quellenangaben. AI formuliert oft sehr überzeugend. Gerade deshalb ist entscheidend zu wissen:

- Woher stammen die Informationen?

- Wie aktuell sind sie?

- Was ist Fakt, was Annahme?

In einer Branche, die mit hohen Werten, langfristigen Verpflichtungen und regulatorischer Verantwortung arbeitet, ist eine Aussage ohne Herkunft keine Information, sondern ein Risiko. Genau diese Logik – Transparenz, Nachvollziehbarkeit, Kontextabhängigkeit – ist auch Kern moderner Risikorahmen für AI (Gebru et al., 2021; NIST, 2023).

Wenn AI nicht nur antwortet, sondern auch handelt

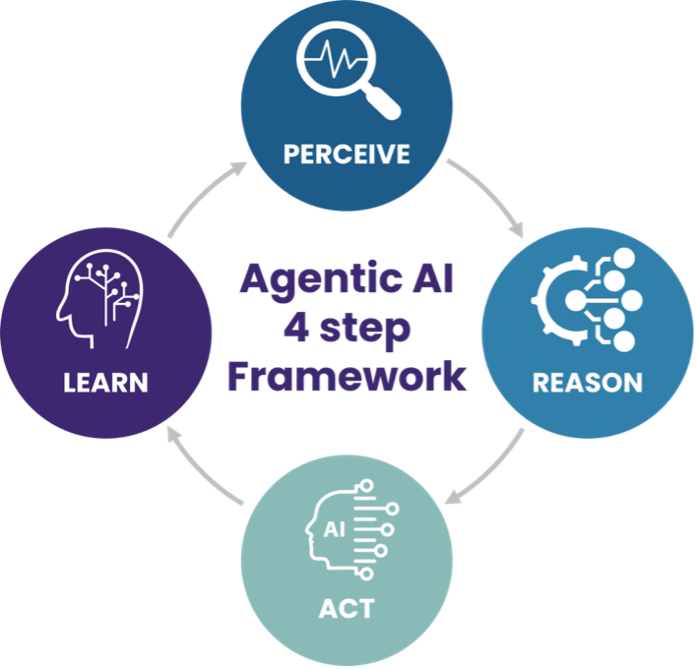

Bisher ging es um AI-Systeme, die analysieren, formulieren und empfehlen. Eine neue Entwicklungsstufe geht darüber hinaus: Systeme, die selbstständig Schritte planen und ausführen – oft als agentische AI bezeichnet (Yao et al., 2023; Bommasani et al., 2022).

Warum sich das Risiko potenziert

Bei klassischen AI-Anwendungen ist ein Fehler oft lokal: eine falsche Antwort oder eine unglückliche Formulierung. Bei agentischen Systemen wirkt ein Fehler fortlaufend: Ein einmal falsch gesetzter Schwerpunkt kann Folgeentscheidungen beeinflussen, Prioritäten verschieben und Prozesse anstossen. Der Fehler bleibt nicht stehen – er „arbeitet weiter“. Das macht Governance nicht überflüssig, sondern wichtiger: klare Grenzen („was darf das System?“), bewusste Freigabepunkte und vollständige Audit Trails über Schritte und Zwischenentscheidungen.

Mit Sicherheit unsicher – und genau deshalb professionell

AI kann Prozesse beschleunigen, Transparenz schaffen und Entscheidungen unterstützen – in allen Disziplinen der Immobilienwirtschaft (NIST, 2023; Amershi et al., 2019).

Aber:

- Tests ersetzen keine Verantwortung,

- gute Ergebnisse ersetzen keine Governance,

- Plausibilität ersetzt keine Prüfung.

Mit Sicherheit unsicher zu sein bedeutet nicht, AI zu misstrauen. Es bedeutet, ihre Grenzen zu kennen, Risiken aktiv zu steuern und Verantwortung nicht aus der Hand zu geben. Das ist keine IT-Frage – das ist professionelles Management.

Von Unsicherheit zu Steuerbarkeit: Wie Unternehmen jetzt vorgehen können

Unsicherheit lässt sich beim Einsatz von AI nicht eliminieren – sie lässt sich nur professionell steuern. Für die Immobilienwirtschaft bedeutet das, AI nicht nur zu evaluieren, sondern sie klar zu führen.

Konkret heisst das:

Unternehmen brauchen praxisnahe Evaluations, definierte Human-in-the-Loop-Freigaben, vollständige Audit Trailsüber Daten, Annahmen und Entscheidungen sowie eine transparente Dokumentation von Zweck und Grenzen eingesetzter Systeme. Diese Massnahmen schaffen Vertrauen – ersetzen aber keine Verantwortung. Sie machen AI beherrschbar, nicht automatisch richtig.

Genau hier setzt die AI@RE-Initiative an. Im AI@RE Transformation Circle erarbeiten Immobilienunternehmen diese Grundlagen gemeinsam: entlang realer Anwendungsfälle, mit Fokus auf Evaluation, Nachvollziehbarkeit und Governance – und mit dem Ziel, AI sicher, verantwortungsvoll und dauerhaft in den operativen Alltag der Branche zu integrieren.

So wird aus „mit Sicherheit unsicher“ kein Hemmnis, sondern ein professioneller Umgang mit AI – als Voraussetzung für nachhaltige Wertschöpfung in der Immobilienwirtschaft.

Das Literaturverzeichnis finden Sie hier.

Wie AI-fit ist Ihr Unternehmen wirklich?

Eine klare Antwort in 10 Minuten.

Mit unserem kostenlosen AI Readiness Check erhalten Sie eine strukturierte Standortbestimmung entlang der entscheidenden Erfolgsfaktoren: Daten. Use Cases. Organisation. Kompetenzen. Governance.

Sie sehen sofort, wo Sie stehen und wo Ihr grösstes Hebelpotenzial liegt.

➔ Jetzt AI Readiness Check starten

(Die Auswertung ist anonym und sofort verfügbar.)

AI @ Real Estate: bleiben Sie am Puls

Unsere Webinarreihe beleuchtet regelmässig aktuelle Fragestellungen an der Schnittstelle von AI und Immobilienwirtschaft.

Nächstes Webinar:

5. März 2026

„Warum AI nicht liefert – und was das über Ihre Organisation aussagt“

Von Erkenntnis zu Umsetzung

In unseren Seminaren und Workshops vertiefen wir die Themen praxisnah und mit konkreter Transferunterstützung für Ihr Unternehmen.

Alle Angebote rund um AI @ Real Estate finden Sie hier.

Kommentare

0 Kommentare

Danke für Ihren Kommentar, wir prüfen dies gerne.