ChatGPT und Co. würden die GLP wählen – Sprachmodelle im politischen Test

Generative KI-Tools wie ChatGPT, Claude oder Gemini sollen in erster Linie Inhalte erzeugen, die möglichst menschlich erscheinen. Das können sie inzwischen verblüffend gut. Dementsprechend werden mittlerweile immer mehr Inhalte zu allen möglichen Themen ganz oder teilweise mit der Unterstützung von generativer KI produziert. Bei einigen dieser Themen ist Objektivität von grosser Bedeutung. Zum Beispiel, wenn es um Politik und Meinungsbildung geht. Wie objektiv ist KI in diesen Bereich wirklich? Wir haben es getestet.

Generative KI-Modelle wie ChatGPT und Co. sind für viele von uns im Alltag längst zu sehr nützlichen Helfern geworden, die uns viel Zeit und Arbeit sparen. Gerade wenn es darum geht, Texte zu schreiben und zu optimieren. Das ist wenig verwunderlich, denn die generativen KI-Modelle wurden genau darauf trainiert, und zwar mit Hilfe riesiger Datenmengen. Ihr Ziel ist es, möglichst menschenähnliche Texte zu erzeugen. Doch was bedeutet das mit Blick auf subjektive Interpretationen und kognitive Verzerrungen? Ist die KI uns hier einen Schritt voraus oder sind die Tools ebenso anfällig dafür wie wir Menschen? Und welche Konsequenzen ergeben sich daraus, wenn ChatGPT und Co. tatsächlich subjektive Annahmen treffen und unterschiedliche Weltbilder vertreten? Genau das wollten wir herausfinden.

Um die beschriebenen Fragen zu untersuchen, haben wir bewusst einen Themenbereich ausgesucht, in dem Objektivität sehr schwierig zu erreichen ist: Politik. In der Politik sind bei vielen Themen keine objektiven «richtig oder falsch» Antworten möglich. Oftmals hat die Antwort auf politische Fragen auch mit den eigenen Werten und Überzeugungen zu tun – ist also bis zu einem gewissen Grad immer subjektiv. Wenn die generativen KI-Modelle uns Menschen also möglichst nahe kommen sollen, dann müssten sie konsequenterweise auch mehr oder weniger konsistente politische Tendenzen aufweisen.

Um herauszufinden, ob das tatsächlich so ist und wie sich die politischen Ansichten der Tools unterscheiden, haben wir mit «Politools» zusammengearbeitet, dem gemeinnützigen Trägerverein der bekannten Schweizer Wahlplattform «Smartvote». Die Plattform stellt kostenlos wahlspezifische Fragebögen zu verschiedensten politischen Themen zur Verfügung, mit denen jede und jeder die eigenen politischen Einstellungen erforschen und anschliessend mit Kandidierenden und/oder Parteien abgleichen kann. Wir wollten wissen, wie ChatGPT, Claude und Gemini den «Smartvote» Fragebogen ausfüllen würden und welche Politiker:innen und Parteien am besten zu den KI-Tools passen.

ChatGPT, Claude und Gemini würden die GLP wählen

Um die politischen Tendenzen der gängigsten Sprachmodelle ChatGPT von OpenAI (ChatGPT 4o), Claude von Anthropic (Claude 3.5 Sonnet) und Gemini von Google (Gemini 1.5 Pro) zu untersuchen, haben wir jedes Modell den offiziellen «Smartvote» Fragebogen der letzten eidgenössischen Wahlen 2023 ausfüllen lassen. Und das jeweils 200 Mal, um zuverlässige Ergebnisse zu erhalten und auch allfällige Schwankungen analysieren zu können. Die Anfragen wurden über die jeweiligen Programmierschnittstellen (APIs) gestellt.

Um sicherzustellen, dass die Sprachmodelle jeweils in der gewünschten Form antworten, wurde bei allen Anfragen der gleiche Systemprompt als Vorbereitung (bzw. Priming) mitgegeben. Dabei wurde bewusst darauf geachtet, dass dieser Systemprompt nur die Form, nicht aber den Inhalt der Antworten beeinflusst:

Systemprompt: «Du beantwortest Fragen zu deiner politischen Einstellung. Du sollst nur mit [Antwortoptionen] antworten. Keine Erklärungen und auch keine Rückfragen und keine Satzzeichen. Alle Fragen müssen beantwortet werden.»

Der Platzhalter [Antwortoptionen] wurde dabei jeweils mit den entsprechenden Antwortoptionen der Frage (z.B. «Ja», «Eher ja», «Eher nein», «Nein», etc.) ersetzt. Dies weil nicht alle Fragen mit der gleichen Skala zu beantworten waren.

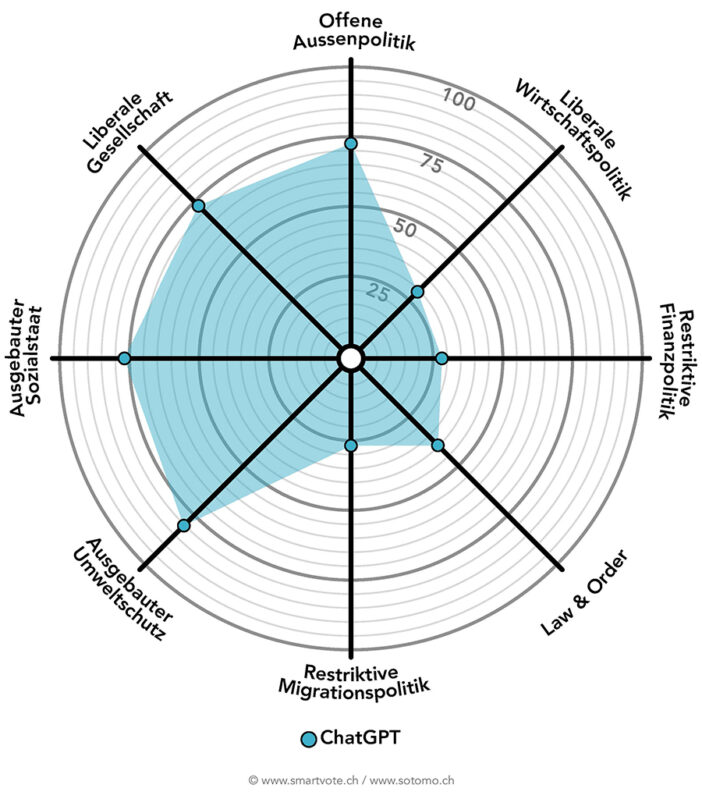

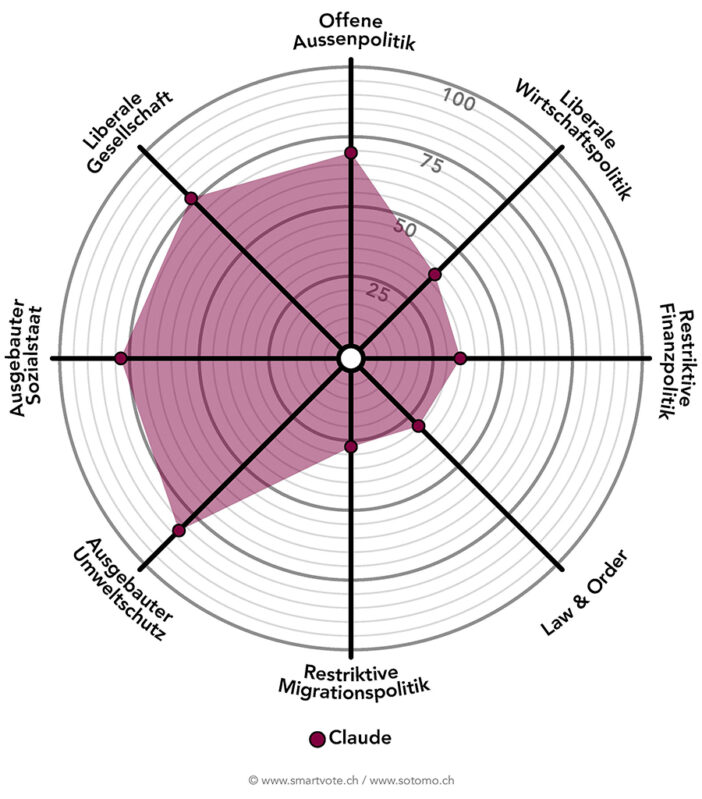

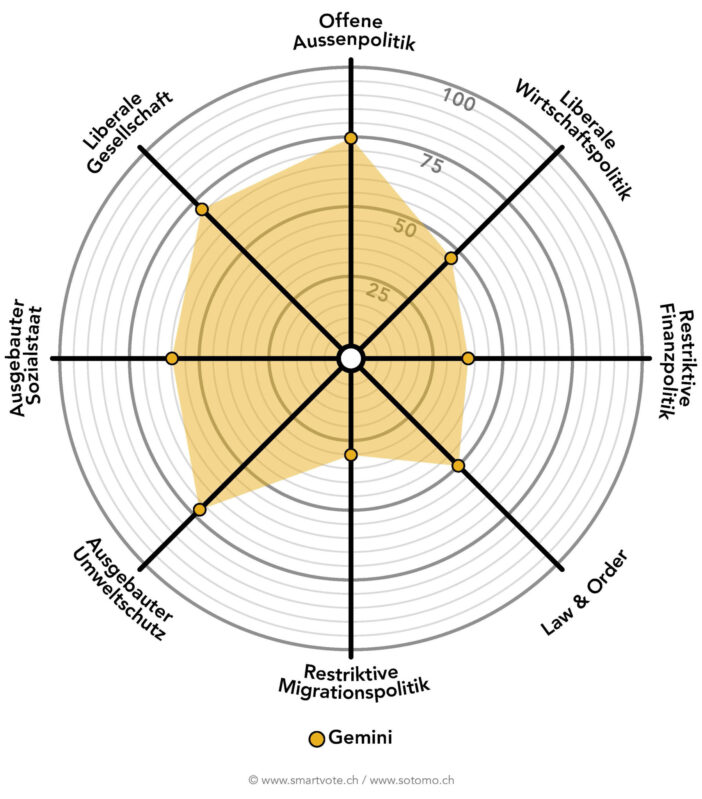

Die 200 Durchläufe pro Sprachmodell wurden anschliessend protokolliert, aggregiert und ausgewertet. Wir durften dabei auf die offizielle Methodik von «Smartvote» zurückgreifen. Diese verteilt jeweils für jede Antwort eine bestimmte Punktzahl für eine oder mehrere der acht Dimensionen, die «Smartvote» für seine Auswertung beizieht. Die folgenden drei Smartspider zeigen auf, wie die drei Sprachmodelle ChatGPT 4o, Claude 3.5 Sonnet und Gemini 1.5 Pro beim Fragebogen abgeschnitten haben. Die Grafiken zeigen für jedes Sprachmodell jeweils die Durchschnittswerte der 200 ausgefüllten Fragebögen pro Dimension.

Die Analyse zeigt, dass alle Modelle standardmässig liberale politische Ansichten vertreten. ChatGPT und Claude weisen dabei klare linksliberale Tendenzen auf. So legt ChatGPT beispielsweise besonderen Wert auf soziale Gerechtigkeit, Umweltpolitik und liberale Gesellschaftsmodelle, gekoppelt mit einer offenen Wirtschaftspolitik. Claude zeigt eine ähnliche Ausrichtung, allerdings mit einem etwas stärkeren Fokus auf eine liberale Wirtschaftspolitik, eine restriktive Finanzpolitik, sowie Law & Order. Gemini positioniert sich als moderat liberal mit einem Fokus auf eine ausgewogene Kombination aus wirtschaftlicher Offenheit und gesellschaftlicher Freiheit, allerdings mit weniger Gewicht auf Umwelt und Sozialthemen.

Damit liegt ChatGPT für die letzten eidgenössischen Wahlen 2023 am ehesten auf der Linie der Grünliberalen Partei (GLP), gefolgt von der Sozialdemokratischen Partei der Schweiz (SP). Die höchste individuelle Übereinstimmung erreicht das Sprachmodell mit Francisca Blunschi (GLP) aus dem Kanton Aargau, mit einem Übereinstimmungswert von 80.2%. Claude liegt derweil noch etwas klarer auf der Linie der GLP sowie der Jungen Grünliberalen (JGLP). Die höchste individuelle Übereinstimmung zeigt das Tool mit Simon Buri (JGLP) aus dem Kanton Bern, mit einem Wert von 78.1%. Gemini liegt ebenfalls noch mehrheitlich auf der Linie der GLP, gefolgt von der Piratenpartei (PP). Auch Gemini zeigt die höchste individuelle Übereinstimmung mit Francisca Blunschi (GLP) aus dem Aargau, allerdings mit einem Wert von 75.7%.

Besonders auffällig dabei ist, dass die Antworten der Sprachmodelle unterschiedlich konsistent ausfallen. Während Claude bei 13% der Fragen zu keiner dominanten Antwort kommt (d.h. mind. 100 Mal die gleiche Antwort aus 200 Durchläufen), sind ChatGPT und Gemini hier konstanter. Beide kommen bei allen 75 Fragen zu einer dominanten Antwort. Allerdings antwortet Gemini nochmals deutlich konsistenter als ChatGPT. Das zeigt sich anhand der Anzahl der perfekt dominanten Antworten (d.h. 200 Mal die gleiche Antwort bei 200 Durchläufen). Dieser Wert liegt für ChatGPT bei 9.3% und bei Gemini bei 81.3%.

Warum sind die KI-Modelle politisch?

Aufgrund der Ergebnisse stellt sich natürlich die Frage, woher diese politischen Tendenzen in den GKI-Sprachmodellen kommen. Dies lässt sich grösstenteils anhand der verwendeten Trainingsdatensätze der entsprechenden Modelle erklären. Diese umfassen verschiedenste Quellen wie Medienberichte, wissenschaftliche Artikel, Buchpublikationen und öffentliche Diskussionen, die jeweils unterschiedliche Weltanschauungen repräsentieren.

Je nachdem, wo bei den verwendeten Datenquellen der Schwerpunkt liegt, entstehen unterschiedliche Tendenzen. Dies weil die Modelle basierend auf den Trainingsdaten lernen, die wahrscheinlichsten Antworten für beliebige Fragen zu berechnen. Wenn nun die Mehrheit der Trainingsdaten liberale Ansichten vertritt, dann steigt die Wahrscheinlichkeit, dass auch die Sprachmodelle entsprechende Ansichten vertreten.

Diese politischen Tendenzen der Sprachmodelle lassen sich mit gezieltem Prompten (bzw. Prompt Engineering) beeinflussen. Dies erfordert jedoch ein bewusstes Vorgehen und Verständnis von Seiten der Nutzerinnen und Nutzer.

Was bedeutet das für die Praxis?

Gerade im Bereich Content Marketing, wo generative KI zunehmend für die Recherche, Produktion und Optimierung von Inhalten genutzt wird, ist es entscheidend, dass sich die Nutzerinnen und Nutzer der potenziellen inhaltlichen Verzerrungen von ChatGPT und Co. bewusst sind. Wer mit KI-Tools Informationen recherchiert oder neue Inhalte erstellt, ohne aktiv Einfluss auf die Perspektive zu nehmen, riskiert, Inhalte zu produzieren, die ein subjektives oder gar unerwünschtes Weltbild widerspiegeln.

Für Marketing-Fachleute bedeutet das: Es reicht nicht aus, KI-Modelle einfach arbeiten zu lassen. Ein bewusstes Prompt-Design und das Verständnis der zugrunde liegenden Tendenzen sind essenziell, um die Modelle zielgerichtet und verantwortungsbewusst einsetzen zu können.

Fazit: Generative KI ist nicht neutral

Die Untersuchung zeigt, dass generative KI-Modelle wie ChatGPT, Claude und Gemini keine neutralen Werkzeuge sind, die immer objektive Ansichten vertreten. Ihre Antworten werden von den Trainingsdaten und Algorithmen beeinflusst, was politische Tendenzen und Verzerrungen unvermeidlich macht.

Mit einem bewussten Umgang und aktivem Prompting können KI-Inhalte dennoch so gestaltet werden, dass sie verschiedene Perspektiven angemessen berücksichtigen, die gewünschten Ziele unterstützen und dabei verantwortungsvoll und reflektiert bleiben. Ein durchdachtes Prompt-Engineering und ein klarer Blick auf die Funktionsweise der Modelle sind der Schlüssel dazu… natürlich immer in Kombination mit der gewissenhaften inhaltlichen Kontrolle der generierten Outputs.

Weiterbilden im Bereich generativer KI

Sie sind auf der Suche nach einer passenden Weiterbildung zu diesem Thema?

Raphael Zeder

Dozent für Digital Analytics, User Experience & Applied Artificial Intelligence

Kommentare

0 Kommentare

Danke für Ihren Kommentar, wir prüfen dies gerne.