Sozialmanagement und Sozialpolitik,

KI in der Sozialen Arbeit: Bedenklich oder ethisch vertretbar?

(KI) überlegt einzusetzen − nicht nur aufgrund des Datenschutzes, sondern auch aus moralischen und ethischen Gründen. Nach Röschs Einschätzung entsprechen viele KI-Programme nicht den Standards der Sozialen Arbeit.

Eike Rösch, Experte für Digitalität im sozialen Bereich, betont die Notwendigkeit, Künstliche Intelligenz

Das Interview führte Roger Ettlin, vom Blog der Sozialen Arbeit, mit Eike Rösch

Egal, wie man über KI spricht, einige Leute werden sich darüber aufregen. Wie ist das im Bereich der Sozialen Arbeit?

Es erstaunt mich und erfreut mich auch ein wenig, dass die Soziale Arbeit so dazu bereit ist, sich für die Künstliche Intelligenz zu öffnen. Früher hat man vielleicht Sachen verpasst, weil man gegenüber neuen Technologien eher kritisch eingestellt war. Jetzt sagen fast alle: «Wow, das müssen wir nutzen.»

Im sozialen Bereich wird normalerweise die Macht grosser Konzerne hinterfragt. Bei ChatGPT und KI ist eher das Gegenteil der Fall. ChatGPT wird als das Ding angesehen. Für mich birgt das gewisse Anzeichen von Unterwerfung. Obwohl die Technologie faszinierend ist, darf man den dahinterstehenden Konzernen nicht blind vertrauen.

Künstliche Intelligenz ist ein Bereich der Informatik, der sich darauf konzentriert, Computern das Wahrnehmen, Denken und Handeln beizubringen, damit sie eigenständig Probleme erkennen und lösen können.

Was verstehst du unter KI?

Der Begriff der Künstlichen Intelligenz sollte differenziert werden. Das lässt sich auf mindestens vier Arten tun:

- Die Technik bzw. der Anwendungsbereiche: Automatisierte Entscheidungssysteme und Large Language Modelle

- Die Anbieter bzw. dem Ort: Gehostete Modelle von grossen Konzernen und lokale Installationen

- Den Funktionsumfang: Breite und enge KI

- Die Eigenständigkeit der Ergebnisse: Starke und schwache KI

Automatisierte Entscheidungssysteme können vorher festgelegte Aufgaben selbstständig lösen oder Entscheidungen automatisch treffen. Im Gegensatz dazu sind Large Language Models in der Lage, Texte zu verstehen, zu übersetzen und Fragen zu beantworten.

Eine zweite Unterscheidung betrifft den Anbieter und den Umgang mit den Daten. Dabei besteht die Möglichkeit, die Daten online zu verarbeiten und zu speichern, wie es bei ChatGPT der Fall ist, oder die Verarbeitung lokal auf dem eigenen Rechner durchzuführen.

Es gibt breite KI-Modelle wie ChatGPT, die eine Vielzahl von Funktionen abdecken. Im Unterschied dazu konzentrieren sich spezialisierte KI-Systeme auf einen bestimmten Bereich.

Und man kann zwischen starker und schwacher KI unterscheiden. Eine schwache KI bearbeitet klar eingegrenzt Aufgaben und hat keine übergreifende Funktion und Intelligenz. Zurzeit gibt es noch keine starken KIs, welche sich weiterentwickeln und ganz neue Aufgaben lösen kann.

Was können Künstliche Intelligenzen?

Die Ergebnisse der KI sind beeindruckend, aber die KI schafft nichts Neues. Vielmehr funktioniert Künstliche Intelligenz wie ein «Stochastischer Papagei», der statistische Muster anwendet. Eine Interaktion kann die KI nur vortäuschen und deshalb ist sie eigentlich eine Hochstaplerin. Sie ist eine hochentwickelte Maschine, die geschickt Informationen verarbeitet, jedoch ohne eigenes Verständnis agiert.

Eine Interaktion kann die KI nur vortäuschen und deshalb ist sie eigentlich eine Hochstaplerin.

Ich kann das Buch «Verteidigung des Menschen» von Thomas Fuchs empfehlen. Fuchs argumentiert, dass der Mensch selbst zunehmend als Produkt von Daten und Algorithmen angesehen wird. Dabei betont er die Bedeutung unserer Leiblichkeit – die untrennbare Verbindung von Körper und Geist – als unsere Essenz. Diese Leiblichkeit fehlt einer Maschine vollständig, was bedeutet, dass sie niemals eigenständiges Denken entwickeln kann.

Du bist sehr kritisch gegenüber KI: Warum sollte man KI nicht einfach verwenden?

Ich bin nicht kritisch gegenüber KI, sondern vor allem gegenüber den Angeboten von grossen Konzernen, da diese sehr unethisch handeln. Für die Gesellschaft hat die Künstliche Intelligenz viele ethische und gesellschaftliche Implikationen.

Grosse Konzerne haben kürzlich ein so genanntes Manifest zu KIs geschrieben und darin einen Stopp der Entwicklung gefordert. Dabei zeigt sich, dass sie die von ihnen aufgestellten Forderungen selbst in keiner Weise erfüllen. Im Gegenteil: Die Angebote dieser Konzerne sind in höchstem Masse unethisch und zielen darauf ab, Machtstrukturen zu etablieren.

Inwiefern gehen diese Konzerne unethisch vor?

Die Erhebung der Daten erfolgt auf unmoralische Weise. ChatGPT hat Daten aus dem gesamten Internet gesammelt, unabhängig davon, ob eine Einwilligung vorlag. Bildgeneratoren erstellen Bilder aufgrund von Werken von Künstler:innen, die keine Entschädigung dafür erhalten. Es ist unethisch, wenn Unternehmen, die lediglich darauf abzielen, Gewinne zu maximieren, Daten in so enormem Umfang sammeln und einfach verwenden.

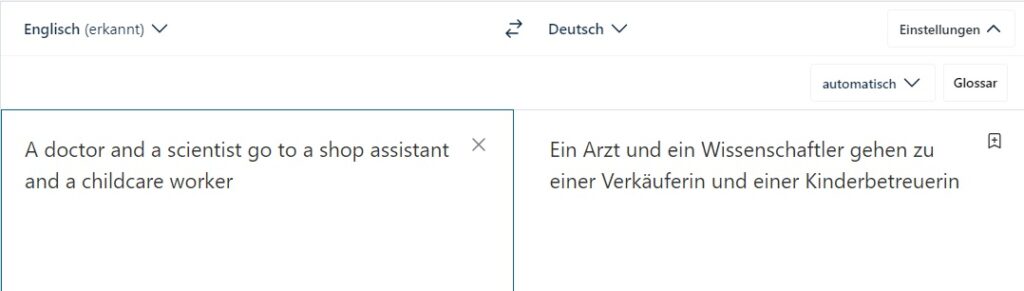

Des Weiteren offenbaren Programme wie ChatGPT oder DeepL einen Bias, was bedeutet, dass ihre Ergebnisse verzerrt sind. Dies liegt daran, dass die Daten überwiegend von Männern aus der westlichen Welt stammen. Ein Beispiel hierfür ist, dass bei DeepL der Begriff «scientist» automatisch ins Männliche übersetzt wird, während «shop assistant» in die weibliche Form «Verkäuferin» übersetzt wird.

Ausserdem wurden Menschen aus armen Ländern, wie zum Beispiel KI-Arbeiter:innen in Kenia, ausgenutzt, um die Programme zu trainieren und zu verbessern. Und nicht zuletzt ist die Künstliche Intelligenz unökologisch, da sie enorme Energiemengen benötigt.

Wie können wir das noch aufhalten?

Wir sind fähig aus den Fehlern der Vergangenheit zu lernen. Wenn wir zurückblicken und sehen, welche immense Macht wir der Google-Suchmaschine übertragen haben, hoffe ich, dass wir diese Erkenntnis nutzen, um verantwortungsbewusster mit der Technologie umzugehen.

Die Frage, die ich mir stelle: Warum sollte man sofort mit KI arbeiten? Es ist nicht notwendig, überstürzt zu handeln. Es hat vorher auch ohne Künstliche Intelligenz funktioniert.

Wie schlägst du vor, mit KI umzugehen?

Um KI zu erfahren, kann man die Tools durchaus ausprobieren. Im ersten Schritt als Privatperson, um zu verstehen, was KI ist und welche Möglichkeiten sie bietet. Anschliessend können Sie sich als Fachperson fragen, ob KI dazu beiträgt, Ihre Arbeit zu vereinfachen. In einem weiteren Schritt ist es wichtig zu überlegen, wie KI verantwortungsbewusst in Ihrem Bereich eingesetzt werden kann, unabhängig von kommerziellen Anbietern. Hierbei ist es ratsam, sich zu vernetzen und externe Expertise einzuholen. Und so können eigene Applikationen entstehen, die gleichzeitig auch unseren Standards entsprechen – und zum guten Leben aller beitragen.

KIs von kommerzieller Anbieter entsprechen oft nicht den ethischen Standards der Sozialen Arbeit.

Wo könnten KI-Anwendungen in der Sozialen Arbeit sinnvoll sein und welche Überlegungen sind dabei zu berücksichtigen?

Wichtig ist, keine KIs kommerzieller Anbieter zu verwenden ohne Vorabklärung. Diese entsprechen oft nicht den ethischen Standards der Sozialen Arbeit, sowohl hinsichtlich des Datenschutzes als auch aus moralischer Perspektive.

Die Anwendungsfelder kristallisieren sich erst noch heraus. Beispiele sind das «Predictive Risk Modeling» im Kindesschutz, bei dem aufgrund vorhandener Daten beurteilt wird, ob ein Fall von Kindeswohlgefährdung vorliegt. Oder die Verwendung von Chatbots, um Informationen aufzunehmen und gezielt mit bestimmten Zielgruppen zu arbeiten.

Ein Beispiel aus der HLSU: Virtual Kids zur Verbesserung der Qualität von Kindesbefragungen

Das Allerwichtigste ist, dass Technologie eine Möglichkeit bietet, aber nicht im Mittelpunkt stehen sollte. Wir müssen die Digitalisierung in der Sozialen Arbeit berücksichtigen, und KI ist eine von vielen Optionen. Dabei dürfen wir jedoch nicht den Fokus auf die Menschen und ihre Bedürfnisse aus den Augen verlieren.

Was findest du besonders wichtig im Bezug auf KI?

Es ist von grosser Bedeutung, dass wir uns in der Digitalität gegenseitig unterstützen. Wir sollten nicht das Gefühl haben, machtlos zu sein. Gemeinsam können wir dafür sorgen, dass die Digitalisierung voranschreitet und dabei auf verantwortungsbewusste Weise gestaltet wird. Darum die Bedürfnisse klären, sich mit anderen Institutionen zusammenschliessen und Expertise von aussen einholen.

Gute Beispiele sind Plattformen für nachhaltige und inklusive Projekte wie «Prototype Fund» oder «Hack for Social Good», die Räume schaffen, um gemeinsam die Digitalisierung im sozialen Bereich zu fördern.

Was kann die Soziale Arbeit zur Debatte der Künstlichen Intelligenz beitragen?

Es ist enorm wichtig, dass die Soziale Arbeit ihre Perspektive einbringt. Andernfalls besteht die Gefahr, dass versucht wird, Probleme im sozialen Bereich zu lösen, ohne dabei die spezifischen Anforderungen und Bedürfnisse zu berücksichtigen.

Informatiker:innen haben sich möglicherweise nicht genug mit den ethischen Fragen auseinandergesetzt. Daher ist es wichtig, die ethische Stimme der Sozialen Arbeit in diesen Diskurs einzubringen.

Von: Roger Ettlin

Bild: Eike Rösch

Veröffentlicht: 6. Juni 2024

Eike Rösch

Eike Rösch beschäftigt sich seit 20 Jahren mit dem Spannungsfeld zwischen Sozialem und Digitalem. Als Erziehungswissenschaftler und Medienpädagoge (mit Wurzeln in der Informatik) war er lange in der Medienpädagogik in der Jugendhilfe tätig, hat als Dozent einer PH das Fach Medien und Informatik mitgestaltet und ausserdem zu Jugendarbeit in der Digitalität promoviert. Als Mitbegründer des Vereins Radarstation begleitet er nun Institutionen der Soziokulturellen Animation auf ihrem Weg in der Digitalität.

Bachelor in Sozialer Arbeit mit Vertiefungsrichtung Sozialarbeit, Soziokultur oder Sozialpädagogik

Das Bachelor-Studium vermittelt das Basiswissen für alle Bereiche der Sozialen Arbeit und fokussiert dann auf die drei Studienrichtungen Sozialarbeit, Soziokultur und Sozialpädagogik. Sozialarbeitende unterstützen Menschen darin, ihr Leben zu bewältigen und selber zu gestalten. In Krisensituationen wie Arbeitsplatzverlust oder Armut vermitteln sie Hilfe. Das Studium kann in Vollzeit, Teilzeit oder berufsbegleitend absolviert werden.

Weitere Informationen: Webseite zum Bachelor in Sozialer Arbeit

Der andere Bachelor: Bachelor in Sozialer Arbeit neue Konzepte und Innovation

Infoveranstaltung: Hier anmelden

CAS Projektmanagement – Der Weg zur erfolgreichen Projektleitung

Projekte nehmen in der Arbeitswelt einen immer grösseren Stellenwert ein, auch im Sozial-, Bildungs- und Gesundheitsbereich. Im CAS-Programm «Projektmanagement» werden die Kompetenzen vermittelt, die es für die erfolgreiche Planung, Durchführung und den Abschluss von Projekten braucht.

Mehr Infos: Webseite CAS Projektmanagement

Kommentare

1 Kommentare

Friedbert Wickel

Sehr spannender Beitrag

Danke für Ihren Kommentar, wir prüfen dies gerne.