Diese Technologie digitalisiert die echte Welt im 3D-Raum: «Forschung im Dialog» erklärt Volumetric Video

Herr Smolic, Ihr Slogan ist «We bring real people into XR». Was meinen Sie damit?

Mit der Volumetric-Video-Technologie lassen sich echte Menschen, Objekte und Umgebungen digitalisieren und in XR-Anwendungen einbinden. Das geschieht über 3D-Scanning und Kameras, die auch Bewegungen erfassen. So entsteht Content aus der realen Welt, der mithilfe von Computergrafik und Computer Vision in Anwendungen wie Games, VR/AR oder Film-Effekten genutzt werden kann – eine echte 3D-Digitalisierung der Realität.

Die Volumetric-Video-Technologie ist effizienter und verleiht mehr Authentizität als rein digital erzeugte Objekte.

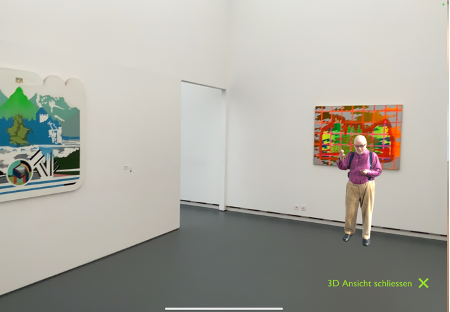

Unsere Forschungsgruppe hat zum Beispiel in einem Innosuisse-Forschungsprojekt mit dem Aargauer Kunsthaus einen Künstler in seinem Atelier volumetrisch aufgenommen. Besuchende konnten im Museum per AR-App erleben, wie ein Maler virtuell vor seinem Bild erscheint und darüber erzählt – eine schöne lokale Anwendung.

Was sind die Vorteile, wenn man echte Menschen und Orte statt digital erzeugter Objekte nutzt?

Wenn man reale Orte oder Objekte digital nachbauen möchte, ist es sehr aufwendig, sie möglichst detailgetreu zu machen. Oft bleibt eine gewisse Künstlichkeit – es sei denn, man investiert sehr viel Geld. Für die FIFA-Spiele werden die Spielergrafiken zum Beispiel durch eine Kombination aus Foto-Scan-Technologie, Motion-Capture-Technologie und digitaler Kunst erstellt. So eine aufwendige Produktion mit viel Equipment steht aber nicht allen zur Verfügung.

Reale Personen und Objekte kann man mittels volumetrischer Videos sehr einfach abbilden. Mit unserer Forschung haben wir es geschafft, die Aufnahmen aus dem Studio rauszubringen und «nach draussen» zu verlagern. Die Bildqualität ist dann zwar nicht gestochen scharf, aber dafür reichen für die Aufnahmen handelsübliche Kameras oder sogar das eigene Smartphone. Die Volumetric-Video-Technologie ist daher nicht nur effizienter, sondern verleiht auch mehr Authentizität als rein digital erzeugte Objekte.

Echte Menschen in einem volumetrischen Video wirken also glaubwürdiger als ein animierter Avatar?

Genau diese Echtheit macht die Technologie so interessant. Derzeit wird volumetrischer Content meist offline produziert: Man nimmt statische Szenen oder ein volumetrisches Video auf und verarbeitet sie anschliessend. Die Forschung zielt jedoch darauf, dies in Echtzeit zu ermöglichen – etwa für Live-Volumetric-Hologramme oder 3D-Videoanrufe im Metaverse, bei denen man sich wie im «Jedi Council» direkt als dreidimensionale Abbilder begegnen kann.

Augmented Reality, Virtual Reality, Mixed Reality und XR erklärt

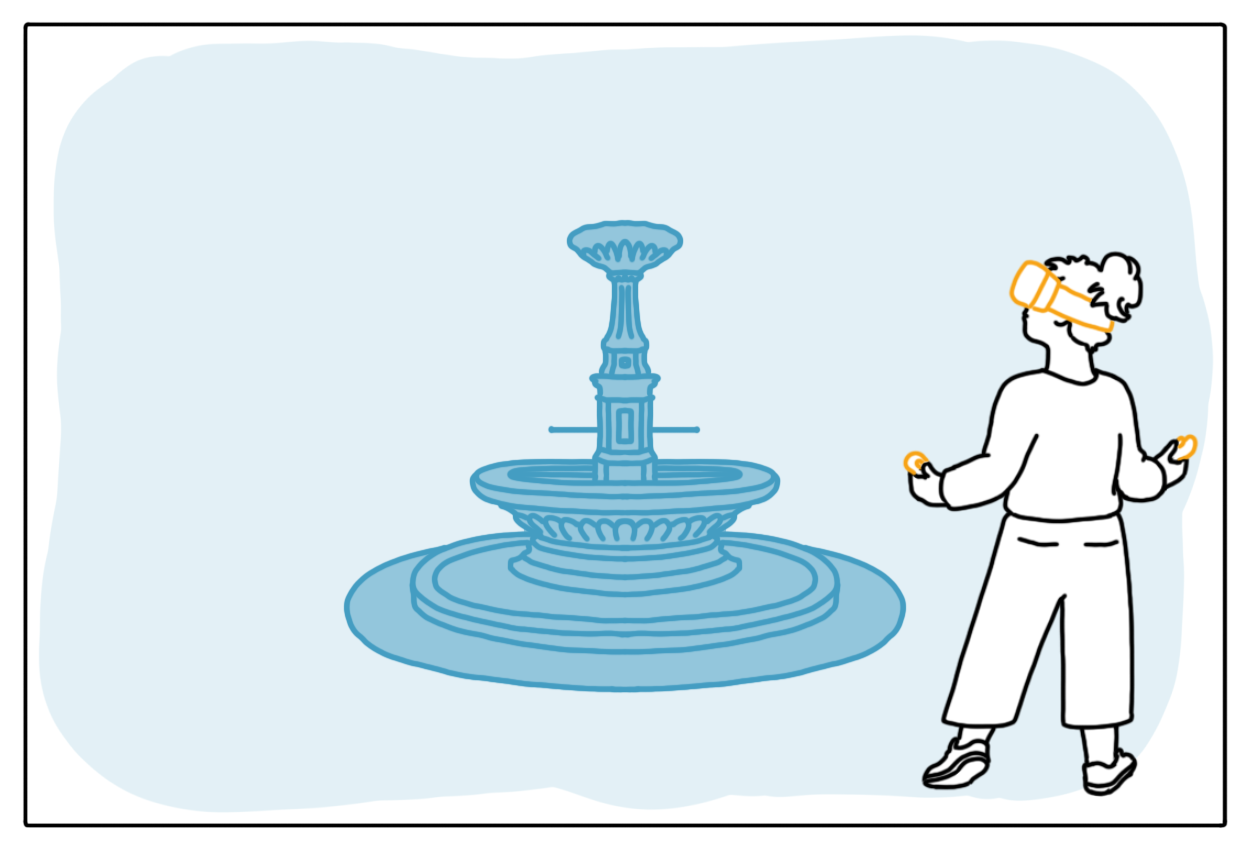

AR steht für «Augmented Reality», zu Deutsch «Erweiterte Realität»: Dank AR-Technologie können die Nutzenden ihre Realitätswahrnehmung erweitern. Dabei überlagern virtuelle Informationen und Objekte ihre reale Welt. So können Hörgeschädigte zum Beispiel in einem Theater eine AR-Brille aufsetzen, die ihnen die gesprochenen Texte schriftlich einblendet.

VR ist die Abkürzung für «Virtual Reality» oder «Virtuelle Realität». Die Nutzenden tauchen dabei in eine vollständig digital erstellte Umgebung ein. Diese Technologie hat sich in den letzten Jahren schnell entwickelt. Sie wird nicht nur in der Spiele- und Unterhaltungsindustrie eingesetzt, sondern auch in diversen Branchen wie Maschinenindustrie, Gesundheitswesen und Architektur. So können Teilnehmende etwa in einer virtuellen Trainingsumgebung Handgriffe auf sichere und effiziente Art und Weise üben. Oder ein Designteam erlebt ein neues Produkt in der virtuellen Betrachtung «wie in echt».

MR bedeutet «Mixed Reality» und wird sehr unterschiedlich verwendet. Aus wissenschaftlicher Perspektive betrachtet umfasst sie das gesamte Spektrum zwischen der physischen Welt, in der wir leben, bis hin zur vollständig virtuellen Realität. Vielfach wird darunter aber auch eine Realität verstanden, die zwischen Virtual und Augmented Reality liegt. Auch hier wird die Realität mit virtuellen Elementen überlagert, aber diese sollen so wirken, als ob sie wirklich Teil der realen Welt wären. Ein Beispiel für dieses MR-Begriffsverständnis ist beispielsweise die HoloLens von Microsoft. In der Branche entfernt man sich jedoch immer weiter davon, AR, MR und VR separat und isoliert zu betrachten. Vielmehr sieht man sie als unterschiedliche Punkte eines Spektrums. Dies führte zu neuen Begriffsbildungen wie «XR». Dabei soll x als Variable die Gesamtheit des Spektrums ausdrücken. Weitere Bedeutungen können sein: «eXtended Reality», «Enhanced Reality», «X-Reality», «Expanded Reality» oder «Cross Reality».

Was steckt denn da technisch dahinter?

Dahinter steckt vor allem Informatik: Computer Vision und Computergrafik. Algorithmen verarbeiten Bilddaten aus Kameras oder Tiefensensoren und erstellen daraus 3D-Modelle. Diese Technologie hat sich über Jahrzehnte stetig verbessert – in den letzten Jahren beschleunigt durch Künstliche Intelligenz.

Wie wird denn ein dreidimensionales Modell aus realen Aufnahmen erzeugt?

3D-Scanner-Apps sind inzwischen weit verbreitet. Man läuft einfach mit dem Smartphone um ein Objekt herum und ein Cloud-Algorithmus erstellt daraus ein 3D-Modell. Entscheidend sind Aufnahmen aus verschiedenen Blickwinkeln, aus denen die grundlegende 3D-Struktur berechnet wird. Solche Techniken werden seit Langem in der Visual-Effects-Welt eingesetzt – inspiriert etwa von den legendären Bullet-Time-Effekten in den Matrix-Filmen.

Braucht es nicht jede Menge Bilder aus allen Blickwinkeln, damit die Visualisierung vollständig wird und kein Loch entsteht, weil von einem Teil keine Bilddaten vorhanden sind?

Genau, je mehr Bilder man hat, desto besser wird das Ergebnis – zumindest theoretisch. Gleichzeitig forschen wir daran, den Aufwand zu reduzieren, also mit möglichst wenigen Aufnahmen trotzdem eine hohe Qualität zu erreichen, um Zeit und Kosten zu sparen.

Welche Rolle spielt KI im Bereich Volumetric Video?

KI hat die technische Entwicklung stark beschleunigt. Die Idee ist, KI-Systeme zu entwickeln, die aus grossen Datensätzen mit 3D-Modellen und den zugehörigen Bildern lernen. So können sie aus einem einzelnen Foto die passende 3D-Struktur berechnen – etwas, das früher aufwendig per Hand mit klassischen Algorithmen entwickelt wurde. Die neuesten Ansätze, an denen wir intensiv forschen, heissen Neural Radiance Fields (NeRFs) und Gaussian Splatting.

Keynote von Aljosa Solic: Wie KI echte Menschen in virtuelle Welten bringt

Das klingt komplex. Können Sie das näher erläutern?

Um das Grundprinzip zu verstehen, lohnt ein Blick zurück: 3D-Struktur zu erkennen ähnelt dem menschlichen Sehen. Wir haben zwei Augen, fixieren einen Punkt aus verschiedenen Blickwinkeln, matchen die Punkte und unser Gehirn leitet daraus die räumliche Tiefe ab. Klassische Computer-Vision-Methoden arbeiten genauso: Mit zwei oder mehr Bildern werden Punkte gematcht und daraus eine Punktwolke erstellt, die die 3D-Struktur definiert.

Die Forschung zielt darauf, dies in Echtzeit zu ermöglichen – etwa für Live-Volumetric-Hologramme oder 3D-Videoanrufe im Metaverse, bei denen man sich wie im ‚Jedi Council‘ direkt als dreidimensionale Abbilder begegnen kann.

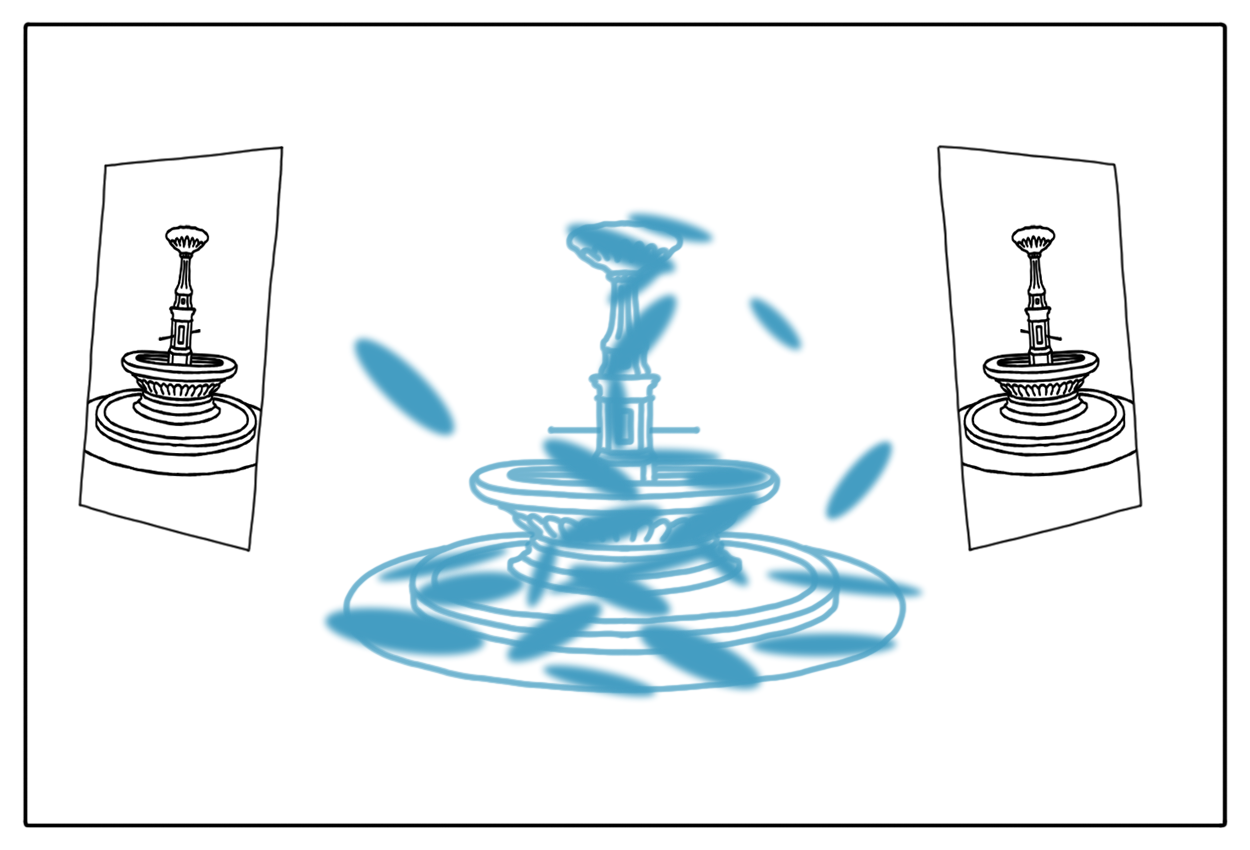

Die neuen KI-Methoden lernen diesen Prozess direkt aus den Daten. NeRFs waren der erste wirklich disruptive Schritt, weil sie aus Bildern direkt ein volumetrisches 3D-Modell erzeugten, ohne klassisches Matching. Das veränderte das gesamte Forschungsfeld und führte zu einer Flut neuer Publikationen.

Inzwischen wurde das Konzept mit Gaussian Splatting weiterentwickelt: Dabei entstehen Punkte im Raum, die nicht nur einzelne Punkte, sondern kleine Ellipsen mit Ausdehnung darstellen und sich wie ein 3D-Modell rendern lassen. Machine Learning ermöglicht, diese Strukturen aus Bildern besonders effizient zu berechnen – darauf basieren heute die modernsten Verfahren.

Gaussian Splatting: Vom Foto zum 3D-Modell

Hier kannst du das 3D-Modell des Brunnens auf der Ufschötti selbst anschauen. Du kannst dich sogar mit der Maus durch die Szene navigieren, drehen und zoomen: lumalabs.ai

Die wichtigsten Verfahren der 3D-Rekonstruktion

Neural Radiance Fields (NeRFs)

Neural Radiance Fields (NeRF) sind ein Verfahren aus dem Bereich des maschinellen Lernens, das verwendet wird, um realistische 3D-Rekonstruktionen aus einer kleinen Anzahl von 2D-Bildern zu modellieren. Dafür wird ein Algorithmus mit einem neuronalen Netzwerk trainiert. Für jeden Punkt in der Szene berechnet das Netzwerk Farbe und Dichte, wodurch anschliessend realistische 3D-Darstellungen erzeugt werden können. NeRFs werden unter anderem in der Computergrafik, in XR-Anwendungen und der Erstellung von digitalen Zwillingen verwendet.

Gaussian Splatting

Gaussian Splatting ist eine Technik im Bereich des Volumenrenderings. Sie nutzt Gausssche Verteilungen, um in kurzer Zeit kontinuierliche und glatte Darstellungen von 3D-Szenen zu erzeugen. Im Vergleich zu NeRFs werden hierbei aber keine neuronalen Netzwerke eingesetzt, sondern Punktewolken in Form von Gaussschen Flecken (engl. «splats»). Gaussian Splats werden oft in Echtzeit-Rendering und Virtual Reality eingesetzt, um detaillierte und realistische Szenen zu generieren.

Photogrammetrie Beim photogrammetrischen Verfahren dienen aus unterschiedlichen Winkeln aufgenommene Fotografien als Grundlage, um eine Punktwolke aus Koordinaten zu erstellen. Diese werden verwendet, um ein digitales 3D-Modell zu rekonstruieren. Durch die leichte Parallaxverschiebung zwischen den unterschiedlichen Bildern kann ein 3D-Objekt rekonstruiert werden.

Finden denn die klassischen Methoden überhaupt noch Anwendung? Wofür eignen sie sich besser und wofür werden eher KI-gestützte Methoden verwendet?

Gaussian Splats sind noch neu, besonders in professionellen Bereichen, in denen klassische Methoden wie Photogrammetrie längst etabliert sind. Diese werden in der Filmindustrie, Architektur, Visualisierung oder Kriminalistik standardmässig eingesetzt – oft auch parallel zu Laserscans, die allerdings spezielle Hardware erfordern. Gaussian Splats bieten nun eine leistungsstarke Alternative und werden sich vermutlich zunehmend verbreiten, zunächst in der Wissenschaft und Filmproduktion. In unseren Forschungsprojekten arbeiten wir bereits mit Partnern aus der Kreativindustrie daran. Dennoch werden klassische Verfahren wie Photogrammetrie und Laserscanner weiterhin parallel genutzt werden.

Sie haben eingangs schon von einem Forschungsprojekt im Aargauer Kunsthaus gesprochen. Können Sie uns von weiteren Projekten berichten, die für Ihre aktuelle Arbeit besonders typisch oder besonders spannend sind?

Wir haben unsere Kerntechnologien in verschiedenen anwendungsorientierten Projekten mit Partnern erprobt und dafür Prototypen entwickelt.

Ein weiteres Beispiel ist das Transmixr-Projekt, bei dem wir zudem zentrale Grundlagen für Gaussian Splatting entwickelt haben. Dort entstand eine VR-App, in der man virtuell mit einem Heissluftballon über das Skisprung-Resort in Planica (Slowenien) fliegt und das realgetreu digitalisierte Gelände erkundet – eine der ersten gross angelegten Anwendungen dieser Technik.

Aktuell arbeiten wir im grossen EU-Projekt HEAT daran, Gaussian Splatting für volumetrisches Video einzusetzen – diese Technologie wurde für Videos nämlich noch nicht oft verwendet. Geplant sind kulturelle Anwendungen: eine Lehr-Experience, eine Theaterproduktion in Sardinien, ein Rock-Blues-Konzert in Transsilvanien und eine Kooperation mit der Irish National Opera. Ziel ist es, diese neuen 3D-Technologien praktisch in Kultur und Live-Performance einzubringen.

Kann ich in Zukunft immersiv an einem Rockkonzert oder einer Theatervorstellung live dabei sein?

Das ist ganz genau die Idee. Natürlich wird das erst mal ein Prototyp sein. Bis zur Marktreife dauert es noch ein bisschen. Aber wir sind sicherlich bei den Ersten mit dabei, die so etwas zeigen und ausprobieren werden.

Ihre Forschung eröffnet dadurch auch neue Ansätze im Journalismus oder in der Krisenbewältigung.

Ja, beim Transmixr-Projekt in Planica haben wir unter anderem mit dem slowenischen Fernsehen und der Nachrichtenagentur AFP zusammengearbeitet und da stand der journalistische Einsatz im Mittelpunkt. Die Idee war, Orte und Ereignisse virtuell erlebbar zu machen, sodass man sie auch aus der Ferne besuchen kann – wie beispielsweise die Skisprungschanze in Planica.

So lässt sich journalistisches Storytelling erweitern: Schauplätze können digitalisiert und dem Publikum immersiv zugänglich gemacht werden.

Das könnte aber auch bei grossen Sportereignissen wie den Olympischen Spielen oder in Krisengebieten denkbar sein. Wir haben deshalb Aufnahme-Tools und Workflows entwickelt, die es Medienschaffenden ermöglichen, vor Ort ohne grosses Equipment 3D-Aufnahmen zu erstellen. So lässt sich journalistisches Storytelling erweitern: Schauplätze können digitalisiert und dem Publikum immersiv zugänglich gemacht werden.

Was sind derzeit noch die grössten Herausforderungen?

In den letzten 25 Jahren hat sich die 3D-Technologie stark weiterentwickelt. 3D-Photogrammetrie ist inzwischen etabliert und sogar auf Smartphones verfügbar, sodass sie in vielen Bereichen eingesetzt wird. Durch neue KI-Verfahren gab es noch einmal einen deutlichen Schub, besonders für statisches 3D-Scanning.

Bei dynamischen Anwendungen wie volumetrischem Video – also bewegten 3D-Aufnahmen – stehen wir aber noch am Anfang. Professionelle Produktionen nutzen solche Verfahren bereits, doch für den breiten Einsatz müssen Qualität und Bedienbarkeit weiter verbessert werden.

Vor allem die Echtzeit-Kommunikation, also holografische Live-Übertragungen wie in einem «Jedi Council», ist noch nicht zufriedenstellend gelöst. Hier braucht es weitere Fortschritte bei den KI-Algorithmen und der Integration in Zielplattformen, damit die Technik einfacher, schneller und zuverlässiger wird.

Wir forschen auch daran, volumetrische Videos animierbar zu machen. Momentan eignen sich volumetrische Videos dazu, die aufgenommenen Sequenzen 1:1 wiederzugeben – nicht aber, sie irgendwie abzuändern. Wir sind aber daran interessiert, eine hybride Form zu entwickeln. Man würde dann zum Beispiel eine reale Person scannen und den Scan dann über ein Basismodell legen, um dieses weiter zu animieren.

Forschung im Dialog: Wissen verständlich auf den Punkt gebracht

Warum forschen wir? Welche Rolle spielt das Informatik-Departement der Hochschule Luzern? In der Reihe «Forschung im Dialog» beantworten unsere Expertinnen und Experten Fragen zur anwendungsorientierten Forschung. Sie beleuchten aktuelle Brennpunkte und geben Einblicke in den Forschungsalltag. Alle Beträge von «Forschung im Dialog» im Überblick.

Wie sieht es mit der Datensicherheit aus?

Daten sind ein weiterer wichtiger Punkt. KI-Modelle werden mit hochaufgelösten 3D-Scans von Menschen trainiert und auch wir erstellen solche Aufnahmen, um unsere Systeme zu optimieren. Das wirft Fragen zu Datenschutz, Privatsphäre und Eigentumsrechten auf. Wenn künftig Systeme in der Lage sind, etwa aus einem einfachen Videoanruf automatisch 3D-Daten zu erzeugen, muss klar geregelt sein, wem diese Daten gehören, wie sie gespeichert werden und wie man die Privatsphäre der Beteiligten zuverlässig schützt.

Wie kamen Sie selbst zum Thema der immersiven Technologien? Was fasziniert Sie daran?

Schon als Doktorand hat mich die damals neue 3D-Rekonstruktion von Menschen und volumetrisches Video fasziniert – inspiriert auch von den Matrix-Filmen. Ich habe Computer Vision, Computergrafik und 3D-Rekonstruktion zu meinem Forschungsgebiet gemacht, und dieses Thema zieht sich bis heute wie ein roter Faden durch meine Karriere, auch wenn ich zwischendurch andere Projekte verfolgt habe.

Meine Vision war das Holodeck aus Star Trek: ein vollständig immersiver Raum, der sich nicht mehr von der Realität unterscheiden lässt. Dieses Ziel motiviert mich bis heute und wird mich sicher noch lange beschäftigen.

Kurz nach meiner Dissertation wurde ich einmal nach meiner langfristigen Vision gefragt. Meine Antwort war das Holodeck aus Star Trek: ein vollständig immersiver Raum, der sich nicht mehr von der Realität unterscheiden lässt. Dieses Ziel motiviert mich bis heute und wird mich sicher noch lange beschäftigen.

Interview: Martina Mach

Veröffentlicht: am 18. Dezember 2025

Experte für immersive Technologien: Aljosa Smolic ist Co-Leiter des Immersive Realities Research Labs der Hochschule Luzern – Informatik. Zuvor leitete er die Forschungsgruppe V-SENSE am Trinity College Dublin und arbeitete bei Disney Research Zürich sowie dem Fraunhofer Heinrich-Hertz-Institut. Seine Expertise liegt in immersiven Technologien wie AR, VR und volumetrischem Video sowie der Integration von Deep Learning in Visual Computing.

Forscht und entwickelt für Organisationen Prototypen: Das Immersive Realities Center (IRC) der HSLU befasst sich mit immersiven Technologien. Diese ermöglichen jene technologischen Ansätze, die das Abtauchen in virtuelle Welten oder Umgebungen erlauben. Forschende entwickeln im integrierten Research Lab Prototypen und Anwendungen. Interessierte Unternehmen und Bildungsstätten aus der Region können im Showroom neue Technologien ausprobieren. Die Forschenden realisieren mithilfe von Expertinnen und Experten Projekte. Dabei greifen sie auf die Infrastruktur des Centers zurück.

Immersive Technologien verstehen – bilden Sie sich aus und weiter:

- Im neuen Bachelor in immersiven Technologien: In diesem Studiengang befassen Sie sich mit Augmented & Virtual Reality, (Serious) Games und immersiven Medienproduktion.

Im CAS Virtual and Augmentet Reality Management: Hier lernen Sie, wie Sie AR- und VR-Projekte im Unternehmen initiieren und leiten. - Im Fachkurs Virtual und Augmented Reality: Dieser Kurs bietet eine Übersicht zu AR und VR und vermittelt neben theoretischen Grundlagen vor allem praxisnahe Inhalte. Die Teilnehmenden gewinnen einen Einblick in die faszinierenden Welten von AR/VR.

🚀Besuchen Sie uns an den Tagen der offenen Tür im Immersive Realities Center. Hier gehts zu weiteren Info-Anlässen der HSLU.

Informatik-Blog abonnieren: In diesem Blog erfahren Sie mehr über Trends aus der Welt der Informatik. Wir bieten Einsichten in unser Departement und Jetzt abonnieren.

Kommentare

0 Kommentare

Danke für Ihren Kommentar, wir prüfen dies gerne.