KI im Ohr: wie Hörgeräte lernen, worauf wir hören wollen

Forschung im Dialog: KI kann helfen, im Stimmengewirr den Überblick zu behalten. Doch das ist erst der Anfang: Künstliche Intelligenz könnte unser Hören grundlegend verändern. Im Projekt DARLING erforscht die HSLU gemeinsam mit Sonova, wie intelligente Hörunterstützung erkennt, welcher Klang gerade wichtig ist – für Menschen mit Hörbeeinträchtigungen ebenso wie für normalhörende Personen in komplexen Alltagssituationen. Lies das Interview mit unserem KI-Forscher Simone Lionetti, hör es dir an – und entdecke erklärende Bilder und Gifs.

Herr Lionetti, Sie beschäftigen sich mit künstlicher Intelligenz in der Medizin. Was kann KI grundsätzlich für die Gesundheit tun?

Simone Lionetti: Unser Gesundheitssystem ist von allen Seiten unter Druck: Es fehlt Personal, die Kosten steigen und Fehler passieren. KI hat das Potenzial, ein Teil der Lösung zu sein. Sie kann Diagnosen vereinfachen, medizinisches Personal unterstützen und mehr Screening-Möglichkeiten schaffen.

🎧 Das Gespräch gibt es auch als Audiointerview. Für alle, die lieber zuhören als lesen:

Kommen wir zu Ihrem aktuellen Projekt mit dem Hörgerätehersteller Sonova. Das Forschungsprojekt heisst DARLING. Was ist daran neu?

Die Idee ist, dass man die Absicht eines Zuhörers oder einer Zuhörerin vorhersagen kann. Also: Worauf will diese Person gerade hören? Wenn wir das abschätzen können, lässt sich die Signalverarbeitung so steuern, dass man genau das hört, was man tatsächlich hören möchte.

Gerade in komplexen akustischen Situationen ist das entscheidend. Menschen mit Hörproblemen sagen uns oft, dass Restaurants, Bars oder Apéro-Situationen zu den schwierigsten gehören. In solchen Momenten gezielt unterstützen zu können, wäre ein grosses Ergebnis.

Kurz erklärt: Was ist DARLING?

DARLING steht für «Detecting And Reacting to Listening Intention aNd Goals» und ist ein Forschungsprojekt der Hochschule Luzern (HSLU) und Sonova, einem weltweit führenden Anbieter von innovativen Lösungen rund um das Hören. Das Projekt untersucht, wie Hörgeräte (und künftig auch Hearables wie Kopfhörer) erkennen können, welcher Klangquelle eine Person gerade folgen möchte. Anders als Ansätze, die Gehirnsignale messen, setzt DARLING auf Audio- und Bewegungsinformationen – und verarbeitet Daten lokal auf dem Gerät.

Das klingt nach «Gedanken lesen». Macht DARLING das?

Nein. Und das ist wichtig. Es gibt in der Forschung Ansätze, bei denen Elektroden am Kopf Gehirnsignale auslesen, um zu erkennen, worauf eine Person hört. Das ist nicht unser Ansatz. Wir versuchen, wie ein normaler Mensch aus Klängen und Körperbewegungen zu verstehen, was in einer Umgebung passiert: Welche Gespräche laufen, welche Quellen gibt es und welche Quelle könnte gerade relevant sein.

Hörgeräte sind winzig. Wie bringt man so viel Rechenleistung ins Ohr?

Das ist eine der grossen Herausforderungen. KI-Forschung ist im Moment oft auf grosse Modelle in Rechenzentren ausgerichtet. Wir gehen in die andere Richtung: so klein und energiesparend wie möglich.

Ein Modell kann technisch zwar auf einem kleinen Gerät laufen, aber jede Berechnung verbraucht Akku. Deshalb nutzen wir bewusst möglichst einfache Lösungen. Nicht nur Deep-Learning-Modelle im klassischen Sinn, sondern auch schlankere Methoden, die zum Gerät passen. Wir verwenden für jeden Schritt das, was am besten passt.

Was war bei der Entwicklung bisher am schwierigsten: die Technik oder das Verständnis des menschlichen Hörens?

Beides. Wir haben Experimente in einem hochspezialisierten Labor durchgeführt. Dieses Setup zuverlässig zum Laufen zu bringen, ist anspruchsvoll. Gleichzeitig war die grösste Herausforderung, die Experimente so zu definieren, dass wir natürliches Alltagsverhalten messen.

Wie muss man sich diese Experimente vorstellen?

Wir haben verschiedene Alltagssituationen nachgebaut. Wichtig war, dass die Messungen die Teilnehmenden nicht einschränken. Nach kurzer Zeit fühlt sich die Situation trotz etwas Equipment ziemlich normal an. Man ist dann wirklich in einer Konversation, wie im Alltag.

War das Hörgerät in diesen Experimenten schon «aktiv»?

Das war ein Grundlagenexperiment. Wir wollten zuerst verstehen: Wie zeigen Menschen, was für sie relevant ist? Welche Körperhaltung, welche Position nehmen sie ein? Reden Menschen gleichzeitig oder nicht? Wie bewegen sie sich im Raum?

Das Besondere dabei: Wir lassen die KI selbst berechnen, welche Muster relevant sind – ohne dass wir für jede mögliche Kombination von Bewegungen und Situationen vorab manuell Regeln erstellen müssen. Spannend ist: Menschen hören sehr unterschiedlich zu. Trotzdem haben wir gute Ergebnisse erzielt. Unsere Modelle konnten mit dieser Vielfalt umgehen und die Objekte der Aufmerksamkeit recht zuverlässig vorhersagen.

Wer profitiert am meisten von dieser Technologie?

Primär Menschen mit Hörproblemen. Viele vermeiden soziale Situationen, weil sie in komplexen akustischen Umgebungen nicht gut interagieren können.

Der «Cocktail Party Effect»

Weltweit leiden gemäss der Weltgesundheitsorganisation WHO fast 500 Millionen Menschen an einem Hörschaden; allein in der Schweiz sind es rund 650’000.

Was bedeutet es, hörgeschädigt zu sein? Menschen mit normal funktionierendem Gehör filtern an einem Fest mühelos die für sie wichtigste Konversation aus dem Lärm heraus – dies wird passend als «Cocktail Party Effect» bezeichnet. Hörgeschädigte hingegen nehmen insbesondere hohe Töne nicht oder nur noch vermindert wahr.

Je schwerer der Hörschaden, desto anstrengender ist für sie daher das Filtern. Als Konsequenz daraus vermeiden Hörgeschädigte oft ermüdende Situationen wie Restaurantbesuche oder Feste und ziehen sich aus dem Sozialleben zurück.

Die Folgen sind gravierend: Einer Studie der Johns Hopkins Universität zufolge leiden Personen mit unbehandelter Schwerhörigkeit 40 Prozent öfters an Depressionen als Personen mit funktionierendem Gehör und weisen ein doppelt so hohes Demenzrisiko auf.

Aber auch Menschen ohne klassische Hörprobleme könnten profitieren. Etwa über smarte Kopfhörer. Es gibt viele Arten von Hörproblemen: Nicht nur «zu leise hören», sondern auch Schwierigkeiten, räumliche Eigenschaften korrekt zu verarbeiten und Stimmen zu trennen. Unser Gehirn macht das normalerweise erstaunlich gut – aber nicht bei allen gleich.

Das Projekt wird von Innosuisse gefördert. Warum ist es gerade jetzt so relevant?

Die Hörgeräteindustrie entwickelt sich rasant, der Wettbewerb ist hoch. Denken Sie an neue Geräte, die Hörunterstützung mit Consumer-Elektronik verbinden. Die Erwartungen steigen. In diesem Projekt kamen viele Elemente zusammen, die eine grössere Innovation möglich machen.

Was ist die eigentliche Innovation – was macht DARLING anders als bestehende Lösungen?

Viele Ansätze arbeiten mit Heuristiken – also einfachen Faustregeln, die schnelle Entscheidungen ermöglichen. Sie verstärken zum Beispiel, was «von vorne» kommt, oder behandeln Stimmen pauschal als wichtigste Quellen. Wir gehen anders vor: Wir schliessen aus dem Verhalten des Menschen und der Interaktion in der Umgebung, was gerade relevant ist.

Wir versuchen durch das Verhalten des Menschen abzuleiten, was jetzt wirklich relevant ist.

Wie weit ist DARLING von einem marktreifen Produkt entfernt?

Im Moment ist DARLING noch ein Konzept. Bis es in vielen Situationen zuverlässig funktioniert und in Systeme integriert werden kann, braucht es noch Arbeit. Das liegt dann stark bei den Herstellern. Aber es zeigt bereits, wie KI unsere Sinne künftig unterstützen kann.

Wenn ein Hörgerät mithört: Was bedeutet das für Datenschutz und Privatsphäre?

Das ist eine zentrale Frage. Wir haben von Beginn weg bewusst darauf geachtet, dass das Gerät alle Daten lokal verarbeitet. Ein Hörgerät muss Audio ohnehin aufnehmen, sonst kann es nichts verstärken. Aber es hat weder die Kapazität noch die Energie, dauernd Daten an Server zu schicken.

Was begeistert Sie persönlich am Projekt?

Die Verbindung von technischen Aspekten des Hörens mit menschlichem Verhalten. Diese beiden Seiten kommen in diesem Projekt wirklich zusammen – und man braucht beide Perspektiven, um gute Ergebnisse zu erzielen.

Wie verändert das Ihre persönliche Wahrnehmung im Alltag?

Ich verhalte mich nicht grundsätzlich anders, aber ich nehme bewusster wahr, was akustisch passiert: Worauf richte ich meine Aufmerksamkeit? Wie zeigen Menschen Interesse an dem, was sie hören wollen, oder wie signalisieren sie, dass sie etwas nicht interessiert?

Wie könnte sich unser Hören in zehn bis zwanzig Jahren verändern?

Ideal wäre, dass wir Stimmen, Musik und Audio immer in bester Qualität hören. Genau das, was wir gerade hören wollen. Hören könnte personalisierter werden.

Ideal wäre, dass wir Stimmen, Musik und Audio immer in bester Qualität hören. Genau das, was wir gerade hören wollen.

Bereits heute gibt es sogenannte Hearables – intelligente In-Ear-Geräte, die nicht nur Musik abspielen, sondern auch die Umgebungsgeräusche filtern und anpassen können. In Zukunft könnte diese Technologie noch weiter gehen: Wir könnten selbst bestimmen, welche Geräusche wir verstärkt wahrnehmen und welche wir ausblenden möchten, genau wie wir Licht heute bereits gestalten.

Hören gestalten wie Licht – wie meinen Sie das?

Hören wird in Zukunft etwas sein, das man aktiv gestaltet. Ähnlich wie Licht, das man dimmen kann – oder das sich dank smarter Einstellungen automatisch an die Situation anpasst, weil man einmal festgelegt hat, wie man es mag.

Verantwortung bleibt beim Menschen – beim Hören wie auch in anderen Anwendungen.

Es gibt schon Lösungen in diese Richtung. So weit sind wir mit unserem DARLING-Projekt noch nicht. Aber ich finde es eine spannende Idee, dass man auch die akustische Umgebung steuern könnte – intuitiv und personalisiert auf die eigenen Bedürfnisse abgestimmt.

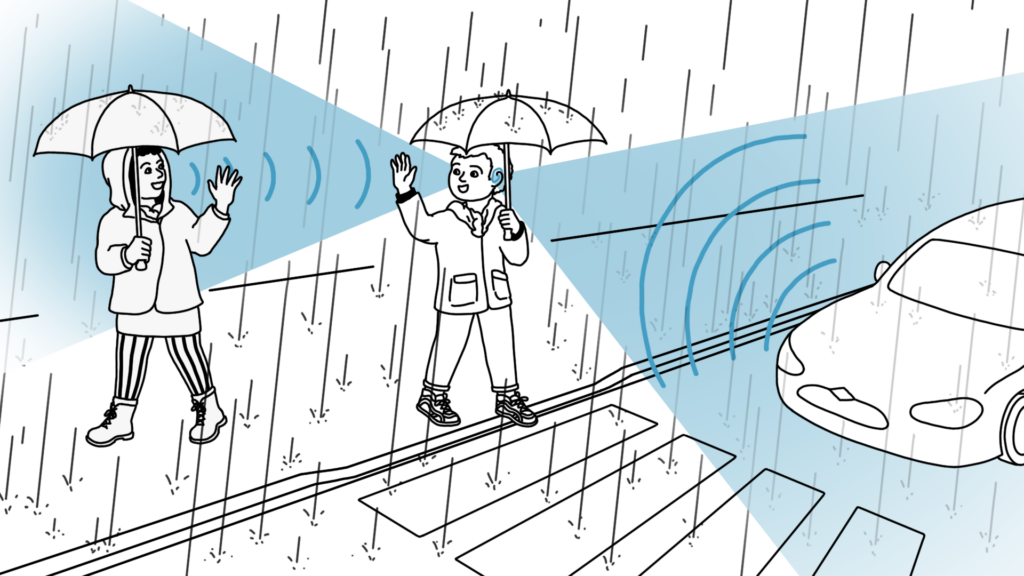

Aber gewisse Geräusche müssen aus Sicherheitsgründen doch hörbar bleiben?

Ja, absolut. Ein Beispiel: Wir müssen Geräusche wie Autos auf der Strasse berücksichtigen. Es kommt gar nicht infrage, dass so etwas unterdrückt wird. Die Schwierigkeit liegt darin, dass wir alles, was wir hören wollen, behalten sollten. Also dass alle Geräusche noch da sind – einfach das, was als wichtigstes eingestuft wird, wird lauter gestellt.

Was sollte KI auf keinen Fall tun?

Entscheidungen treffen, die nur Menschen verantworten können. Verantwortung bleibt beim Menschen – beim Hören wie auch in anderen Anwendungen.

Forschung im Dialog: Wissen verständlich auf den Punkt gebracht

Warum forschen wir? Welche Rolle spielt das Informatik-Departement der Hochschule Luzern? In der Reihe «Forschung im Dialog» beantworten unsere Expertinnen und Experten Fragen zur anwendungsorientierten Forschung. Sie beleuchten aktuelle Brennpunkte und geben Einblicke in den Forschungsalltag. Alle Beträge von «Forschung im Dialog» im Überblick.

Interview: Yasmin Billeter

Veröffentlicht: am 19. Februar 2026

Experte: Dr. Simone Lionetti, Applied AI Research Lab, Hochschule Luzern – Informatik

Experte für angewandte KI und maschinelles Lernen: Simone Lionetti ist Dozent und Forscher am Applied AI Research Lab der Hochschule Luzern – Informatik. Er promovierte in Physik an der ETH Zürich und war anschliessend als Postdoctoral Fellow an der Durham University tätig. Seine Expertise liegt in der Entwicklung von KI-Algorithmen für medizinische und akustische Anwendungen sowie in der datengetriebenen Signalverarbeitung.

Entwickelt KI-Lösungen für reale Herausforderungen: Das Applied AI Research Lab (AAI) der HSLU widmet sich der angewandten Forschung im Bereich künstlicher Intelligenz. Die Forschenden entwickeln und evaluieren Modelle des maschinellen Lernens. Von der Bildverarbeitung über Audiosignale bis hin zu medizinischen Anwendungen. Dabei arbeiten sie eng mit Unternehmen, Start-ups und Forschungseinrichtungen aus Branchen wie MedTech, Sport und Retail zusammen. Ziel ist es, massgeschneiderte KI-Lösungen zu entwickeln, die direkt in der Praxis eingesetzt werden können.

Informatik-Blog abonnieren: In diesem Blog erfahren Sie mehr über Trends aus der Welt der Informatik. Wir bieten Einsichten in unser Departement und Jetzt abonnieren.

Kommentare

0 Kommentare

Danke für Ihren Kommentar, wir prüfen dies gerne.