«Künstliche Intelligenz gibt es eigentlich nicht»

Vorsicht vor falschen Erwartungen oder unnötigen Ängsten! Ein Interview mit Ladan Pooyan-Weihs, Co-Studienleiterin unseres CAS Artificial Intelligence über «erweiterte Intelligenz» und digitale Ethik.

Von Gabriela Bonin

Hier aufklappen und Aktualisierung vom Dezember 2023 lesen: Wie umgehen mit Risiken? «Es braucht mehr Bildung im Umgang mit KI-Themen»

Ende 2023 aktualisieren wir dieses Interview. Denn mittlerweile demonstriert ChatGPT einer breiten Öffentlichkeit die Fortschritte generativer Künstlicher Intelligenz. Das freut die einen und ängstigt die anderen. Derzeit fordern über 3000 Unterzeichnende, CEOs und führende Forschende in einem offenen Brief eine sechsmonatige Entwicklungspause für das Training von KI-Systemen. Zunehmend wird vor dem sogenannten Alignment-Problem gewarnt, der Gefahr, dass zukünftige KI-Systeme die menschliche Zivilisation bedrohen könnten.

Frau Pooyan-Weihs, was entgegnen Sie heute jenen, die vor einer bedrohlichen Künstlichen allgemeinen Intelligenz (AGI) warnen?

Man muss mögliche Gefahren ernst nehmen. Das Thema ist wichtig. Das zeigt allein schon der KI-Gipfel zur Sicherheit von künstlicher Intelligenz, der im November 2023 im historisch bedeutsamen Bletchley Park im Norden von London stattfand. Während des Zweiten Weltkriegs war dieses Landgut das emblematische Entschlüsselungszentrum für Codes. An diesem KI-Gipfel beteiligten sich Leute mit Macht, Rang und Namen. Die EU will KI regulieren. Gleichzeitig erarbeitet der Europarat KI-Rahmenbedingungen. Ich begrüsse das und plädiere für Regulierungen.

Auch unterstütze ich den Vorschlag der Universität Luzern, eine Internationale Agentur für datenbasierte Systeme (IDA) zu gründen. Dies bei der Uno als Zulassungsbehörde. Datenbasierte Systeme sollen die Menschenrechte einhalten. Einerseits ist es erfreulich, wie fortgeschritten KI-Forschung und -Entwicklung sind. Andererseits müssen wir uns um ihre sichere und friedliche Nutzung bemühen. Eine IDA könnte ähnlich wirken wie die Internationalen Atomenergiebehörde (IAEA) im Nuklearbereich.

Haben Sie den offenen Brief von tausenden KI-Fachleuten auch unterzeichnet?

Nein. Ich denke, dahinter steckt eine andere Absicht. Es wird so getan, als ob wir vor einer nicht begreifbaren wissenschaftlichen Entwicklung stehen, die sich rasant entwickelt. Dabei basiert sie auf langjähriger Forschung. Justine Cassel arbeitet seit 29 Jahren an einem Embodied Conversational Agent (ECA), einen virtuellen «Menschen», der mit Menschen interagieren kann. Ihr «virtuelles Kind» hat autistischen Kindern geholfen, ihre sozialen Fähigkeiten weiterzuentwickeln.

Dieser Brief lenkt von den eigentlichen Problemen ab. Er verweist auf künftige Gefahren, zeichnet das Schreckensbild von Super-KI-Intelligenzen, die dereinst die Menschheit vernichten könnten. Stattdessen sollten wir uns auf die aktuellen, realen Probleme und Herausforderungen konzentrieren.

Welche aktuellen Probleme gilt es anzupacken?

Wir sollen uns um den Schutz unserer privater Daten und unserer Privatsphäre kümmern. Grosse Tech-Konzerne verdienen sehr viel Geld daran und es ist kein Geheimnis, dass sie uns damit schaden. KI beschleunigt die Verbreitung von Fake News. Das bedroht demokratische Werte. Im KI-Systemen werden bestehende gesellschaftliche Diskriminierungen verstärkt. All das muss meiner Meinung nach angegangen werden. Die italienische Datenschutzbehörde liess im Frühling 2023 ChatGPT vorübergehend sperren. Denn ChatGPT sammelt und verarbeitet grosse Mengen an persönlichen Daten. Geraten diese Daten in falsche Hände, können sie für illegale oder bösartige Zwecke missbraucht werden.

Das sind aus meiner Sicht die wahren, aktuellen Probleme. Davor muss man die Menschen schützen, nicht vor futuristischen Schreckens-Szenarien.

Die grossen globalen Tech-Konzerne betreiben viel Lobbying, um ihre Interessen zu vertreten. Es geht um sehr viel Geld und Macht. Ich denke, sie wollen bei Regulierungen mitreden, um diese zu schwächen. Darum sage ich, der offene Brief ist ein Ablenkungsmanöver. Es gibt ein Machtgefälle zwischen diesen Tech-Unternehmen und den Staaten. Mit griffigen KI-Regulationen lässt sich kein Geld verdienen. Deshalb schicken die Firmen Leute nach Brüssel oder London. Sie lobbyieren dafür, KI-Regulationen so oberflächlich wie nur möglich zu gestalten.

Wenn so viele Fachleute vor Gefahren warnen, muss was Wahres dran sein, oder nicht?

Die Sache ist komplex. Selbstverständlich muss man dafür sorgen, dass diese Technologie den Menschen nützt und nicht schadet. Aber schauen wir mal genauer hin: ChatGPT zum Beispiel ist ohne Zweifel ein Meilenstein in der KI-Entwicklung. Auch die neuen Modelle zur generativen Bilderzeugung liefern beeindruckende Resultate.

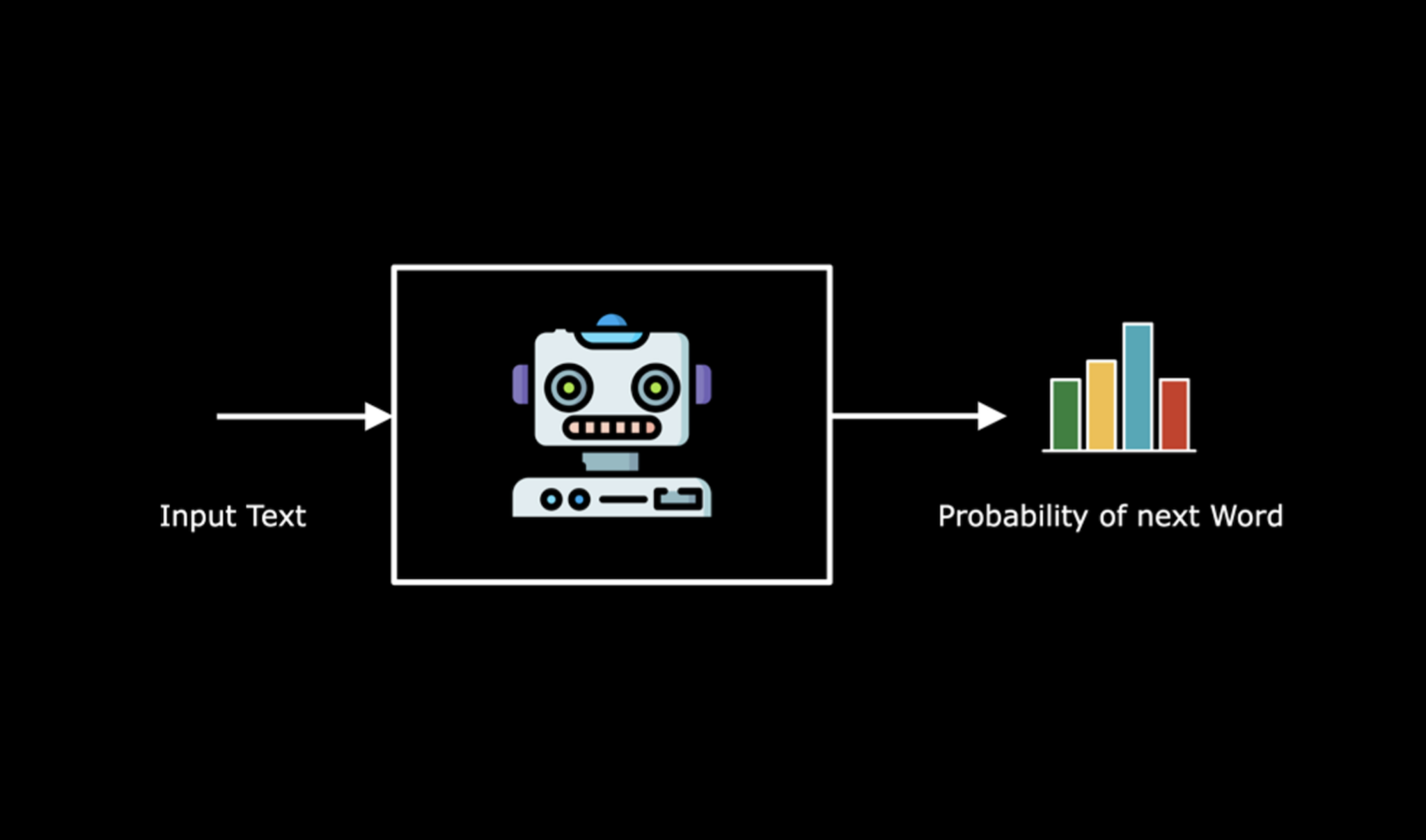

Denken wir aber daran, wie sie funktionieren: Sie basieren auf einer Kombination von Semisupervised und Reinforcement Learing: Dieses teilüberwachte und bestärkende Lernen funktioniert nur mit sehr viel menschlichem Einsatz. Menschen trainieren diese Systeme mit grossem Aufwand. Ihr Erfolg basiert auf menschlichem Einsatz.

Hinter einer KI, die Bilder entwickelt steckt keine Kreativität – sondern schlicht Training. Sie wurde gezielt berechnet. Das basiert auf fantastischer menschlicher und rechnerischer Leistung, aber nicht auf einem Bewusstsein.

Technische Fortschritte sind erfreulich, aber oft missverstanden, wie etwa die Behauptung, KI könne Krankheiten heilen. Vielmehr werden KIs gezielt auf eine bestimmte Problemstellung hin programmiert. Sie sind präziser, schneller, unermüdlicher als Menschen. Sie haben kein Bewusstsein, keine Moralfähigkeit und vieles mehr, das uns Menschen ausmacht.

Chatbots wie ChatGPT werden so trainiert, dass sie menschlich wirken.

Ja, und da muss man gut aufpassen. Diese KI-Modell werden mit neurowissenschaftlicher Expertise auf Plausibilität hintrainiert. Etwas, das plausibel klingt, ist aber noch nicht unbedingt wahr und richtig. Wir Menschen müssen das verstehen, wenn wir sicher mit diesen Maschinen zusammenarbeiten wollen. Wir müssen lernen, zwischen richtig, falsch und plausibel zu unterscheiden. Es gilt, das kritische Denken zu fördern.

Da sind die Bildungsinstitute gefragt. Es ist nötig, mehr Bildung und Sensibilität im Umgang mit KI-Systemen zu fördern.

Interview vom Juni 2020: Frau Pooyan, Sie halten den Begriff «Künstliche Intelligenz» (KI) für irreführend. Was stört Sie daran?

Ladan Pooyan-Weihs: Über «Künstliche Intelligenz» wird alles Mögliche behauptet, obschon es noch keine allgemeingültige Definition der Intelligenz gibt. Der Begriff führt in die Irre. Das geschieht zum Beispiel auch, wenn wir im Zusammenhang mit Informationstechnologie von «Viren» sprechen. Mit einer derartigen Wortwahl schaffen wir eine negative Vorstellung von einer Software, die eigentlich einfach zu meistern ist.

Inwiefern führen solche Begriffe in die Irre?

Sie können Angst auslösen, weil sie nicht wertneutral sind. Der Mensch träumt schon lange von übermenschartigen Wesen, die oft gewaltige Grösse und Kraft besitzen und ausserordentliche, körperlich schwere Aufträge blitzschnell ausführen können. Zugleich fürchtet er aber auch, dass diese nach einiger Zeit unkontrollierbar werden. Schauen wir uns nur die Entwicklung des legendären Golem in der jüdischen mittelalterlichen Literatur an oder von Frankenstein in neuer Zeit. Falsche Begriffe verleiten uns zu falschen Vorstellungen und Schlussfolgerungen.

Immerhin verhelfen diese einfach verständlichen Begriffe auch Laien zu einer Vorstellung von der Sache …

Das ist gerade das Problem: Mit solchen Begriffen werden unsere Gefühle angesprochen. Sie beeinflussen unsere persönliche Beziehung zu einem Thema. In diesem Fall führen sie zu Fantasterei, überhöhten Erwartungen oder umgekehrt zu beklemmenden Gefühlen. Das hindert uns daran, eine sachliche Diskussion zu führen.

Wie können wir uns denn nüchtern über «Künstliche Intelligenz» unterhalten?

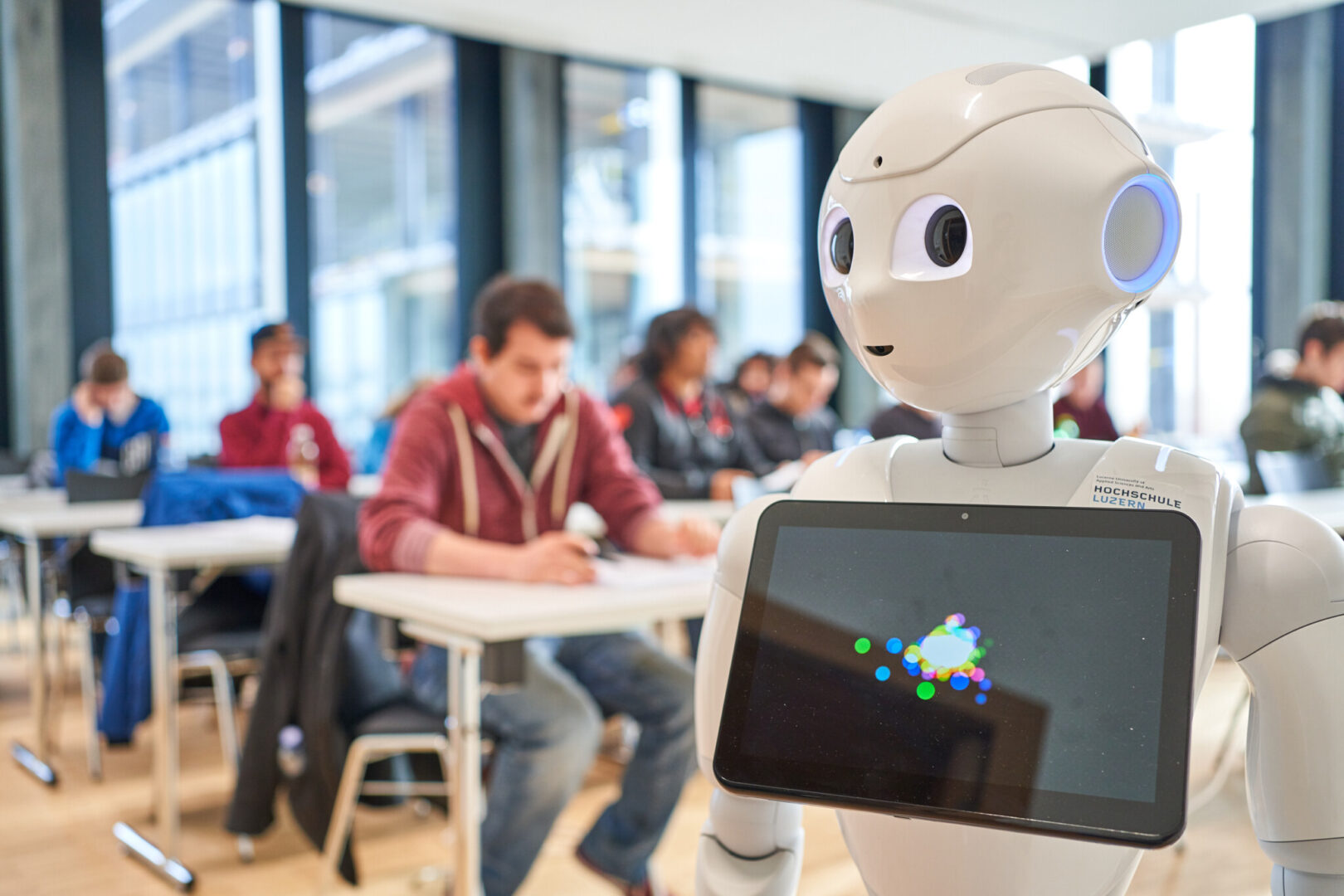

Zunächst sollten wir den Begriff anders fassen und von «Erweiterter Intelligenz» sprechen. Denn jedes Stück Software ist ein Stück erweiterte menschliche Intelligenz. Es sind nicht Roboter, die ein Computerprogramm bestimmen – es sind wir Menschen! Unsere Intelligenz steckt dahinter, nicht eine künstliche Intelligenz. Wir bestimmen, wie KI-Programme arbeiten sollen. Ziehen wir also keine Science-Fiction-Visionen herbei, sondern gehen wir bewusst mit der Thematik um!

Es sind nicht Roboter, die ein Computerprogramm bestimmen – es sind wir Menschen.

Da Menschen hinter den Programmen stecken, kann man also nicht von «Künstlicher Intelligenz» sprechen?

Allein schon der Begriff «Intelligenz» ist bis heute auch in Fachkreisen nicht eindeutig bestimmt. Ich verstehe unter Intelligenz die Fähigkeit, innovativ zu sein, Regeln zu brechen, sich für das noch Unbekannte zu interessieren. Intelligent zu sein bedeutet, Neugierde zu haben. Intelligenz ist dynamisch, global wirksam, abstraktions- und entwicklungsfähig.

Heisst das, dass wir Menschen dank dieser Art von Intelligenz auch in Zukunft sogenannt «intelligenten» Maschinen und Robotern überlegen sein werden?

Ja, weil wir über das Erlaubte und Bekannte hinausgehen können. Wir vermögen es, die Regeln und Überzeugungen des Augenblicks zu brechen. Innovative Menschen bringen sich freiwillig in unbequeme Situationen, indem sie sich mit Menschen aus völlig anderen Fachbereichen oder mit komplett anderen Ansichten austauschen. Sie wenden die bekannten Regeln eines Bereichs auf einen anderen an. Sie stellen eigenes Wissen infrage. Innovation wird aus dem Zweifel und dem Hinterfragen heraus geboren. Ebenso entwickelt sie sich aus Emotionen und Ehrgeiz heraus und vor allem aus dem ethischen Bedürfnis, etwas Gutes für die Menschheit zu tun.

Derartige Bedürfnisse und Gefühle haben Maschinen nicht …

Eine Maschine zweifelt nicht. Sie hinterfragt nicht. Ein Roboter hat kein Verlangen nach einer Wertschöpfung für die Menschheit, nach Frieden oder dem Gemeinwohl. Maschinen tun, was sie tun sollen – und zwar so, wie sie von uns Menschen programmiert wurden. Wenn Intelligenz also mit Innovationsfähigkeit und inneren Antrieben einhergeht, kann eine Maschine dann intelligent sein? Selbst eine starke KI kann ihre Schlüsse noch nicht auf andere Gebiete übertragen. Solange Computer kein Einfühlungsvermögen für Lebewesen haben, solange sie weder Sinn für Humor noch die Fähigkeit besitzen, von einer Situation in eine andere zu springen, wird es keine Künstliche Intelligenz geben.

Was genau kann denn KI beziehungsweise die Erweiterte Intelligenz?

Sie kann menschliches Lernen und Denken auf den Computer übertragen. KI-Programme arbeiten fehlerfrei, schneller und effizienter als Menschen. Sie tun das auf ressourceneffiziente Weise im 24/7-Modus. Sie werden nie müde. Ihre Leistung wird weder durch Trauer, Verluste noch durch Liebeskummer gesenkt. Schauen wir die berühmten Computerprogramme aus dem Bereich der künstlichen Intelligenz an, wie etwa AlphaGo, Watson oder Deep Blue: Sie benutzen Strategien, Argumentationen und Wege, die sich sehr von jenen unterscheiden, die ein menschliches Gehirn genommen hätte. Denn KI kann zum Beispiel Muster in Daten effizienter erkennen als Menschen.

In Bezug auf Effizienz, Konstanz und Schnelligkeit sind KI also besser als wir Menschen. Wird man ihnen künftig nicht auch Empathie oder Innovationsgeist einprogrammieren können?

Denken wir an Eigenschaften wie Einfühlungsvermögen und Humor: Es gibt auch Menschen, die diese Wesenszüge nicht aufweisen. Wir wissen selbst noch nicht, wie sie überhaupt zustande kommen. Erst wenn wir dies verstehen, können wir versuchen, diese Kenntnisse auf eine Maschine zu übertragen. Egal, wie komplex ein Programm ist, es widerspiegelt immer nur das, was wir selbst verstanden und ihm beigebracht haben. Das ist auch so beim «Maschinellen Lernen», der künstlichen Generierung von Wissen und Erfahrung: «Machine Learning» verkörpert, einfach gesagt, nur eine riesige Datenbank, der wir alles «gelehrt» haben. Maschinen haben keine eigenen Ideen, sie beziehen sich auf Spielregeln, die wir ihnen diktieren.

Demnach braucht man sich nicht vor gefährlichen künstlichen Superintelligenzen zu fürchten, sondern vielmehr vor den Fehlern der Menschen?

Ja, die eigentliche Gefahr in Bezug auf KI und Roboter geht von uns Menschen aus. Zum Beispiel dann, wenn wir bewusst Killerroboter programmieren oder rassistische oder frauenfeindliche Chatbots erstellen. Es gibt keine Künstliche Intelligenz ausserhalb unserer menschlichen Kontrolle, die unsere Ausrottung herbeiführen könnte.

Die eigentliche Gefahr in Bezug auf KI und Roboter geht von uns Menschen aus

Wie verhindern wir, dass Menschen unbedachte oder gefährliche Programme entwickeln?

Mittels Regulierungen. Es ist unsere Pflicht als Informatikerinnen und Informatiker, unsere demokratischen Institutionen zu informieren und zu alarmieren, damit sie alle notwendigen Mechanismen zur Verhinderung von Missbräuchen einführen.

Es bräuchte so quasi einen Hippokratischen Eid für Informatikerinnen und Informatiker – ein Gelöbnis für digitale Ethik.

Den gibt es bereits, nur ist er nicht bindend: Der «Holberton-Turing-Eid» für Entwicklerinnen und Entwickler von Algorithmen stellt die Menschlichkeit über die Technik. Wir sind noch weit davon entfernt, dass ein derartiger Eid zum Beispiel bei einem Staatsexamen abgelegt würde. Es gibt nur Einzelinitiativen, aber keine umfassenden, weltweit verbindlichen Richtlinien. In Frankreich kenne ich zum Beispiel die Initiative «Data for Good».

Sie sind daran beteiligt, am Informatik-Departement der Hochschule Luzern ein neues CAS-Ausbildungsprogramm für «Digitale Ethik» aufzubauen. Warum ist Ihnen das wichtig?

Das liegt mir sehr am Herzen. Die Digitalisierung erreicht alle Lebensbereiche der Gesellschaft und Wirtschaft – weitgehend ohne grundlegende ethische Überlegungen und ohne ganzheitliche politische Regulierungen. Wir Informatikerinnen und Informatiker spielen eine wesentliche Rolle dabei und müssen daher die Weichen heute achtsam stellen und Verantwortung übernehmen.

Welche Fachleute waren für Sie in diesen Fragen inspirierend?

Der französisch-amerikanische Mathematiker und Informatiker Luc Julia hat mir sehr geholfen, diese Thematik einzuordnen. Ich habe sein Fachbuch «There is no such thing as artificial intelligence» sehr interessant gefunden («Es gibt keine künstliche Intelligenz», das Buch erschien nur auf Englisch und Französisch). Ich selbst fand den Begriff «Künstliche Intelligenz» schon lange irreführend. Julias Buch hat mich in meinen Ansichten bestätigt. In ethischen Fragen bin ich inspiriert von der Wirtschaftsinformatikerin Sarah Spiekermann sowie von Corinna Bath, Professorin für Gender, Technik und Mobilität.

Wer hat den Begriff «Künstliche Intelligenz» denn eingeführt?

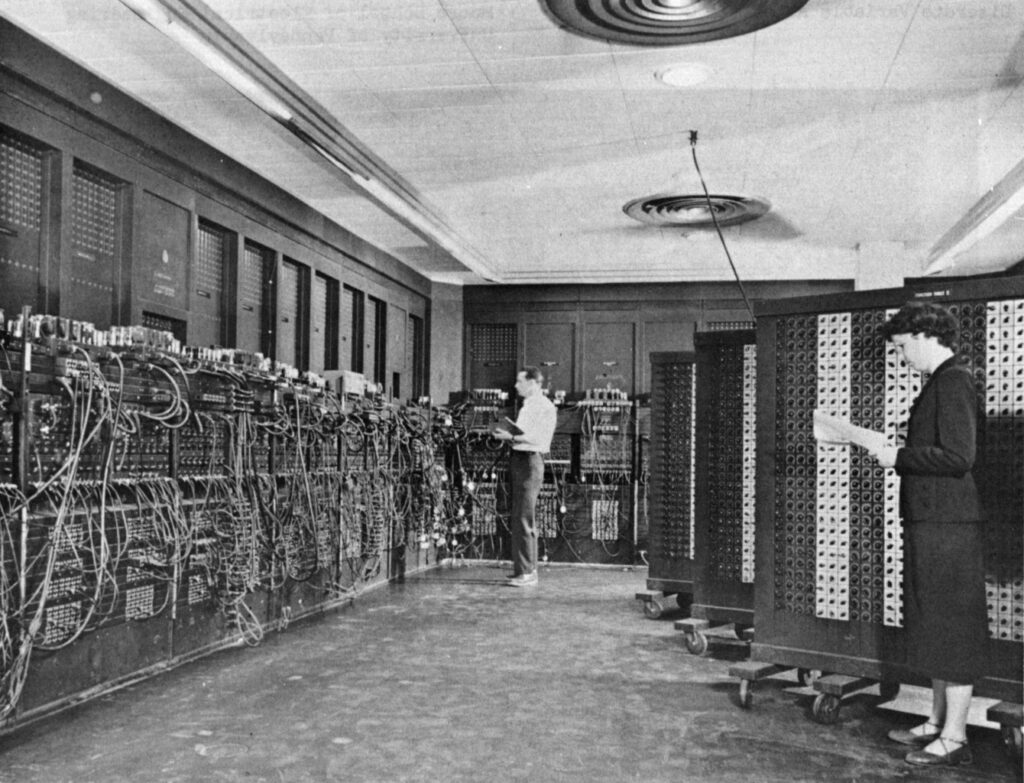

Der US-amerikanische Informatiker John McCarthy hat ihn 1956 auf der Dartmouth Conference geprägt. Dieses Forschungsprojekt gilt als die Geburtsstunde der Künstlichen Intelligenz als akademisches Fachgebiet. Das Ziel war es, innerhalb von drei Monaten in Maschinen die Mechanismen des menschlichen Gehirns nachzubilden.

Welche Art von KI wünschen Sie sich?

Ich möchte, dass wir KI zum Schutz und für eine positive Entwicklung der Menschheit einsetzen. Sie soll keine Entscheidungen für uns treffen. Sie sollte uns aber helfen, blitzschnell ethisch fundierte Entscheidungen zu fällen.

Veröffentlicht im Juni 2020, aktualisiert im Dezember 2023

Informatikerin mit ethischen Ansprüchen: Ladan Pooyan-Weihs ist Professorin und Dozentin an der Hochschule Luzern – Informatik. Sie leitet das Themenfeld Digital Transformation. und beteiligt sich an der Entwicklung des neuen CAS Digital Ethics Management Pooyan-Weihs engagiert sich am Department Informatik auch als Diversity-Beauftragte.

Mehr über KI erfahren: Lesen Sie zu diesem Thema auch unser Interview mit Donnacha Daly, Studiengangleiter des Bachelor-Studiums Artficial Intelligence & Machine Learning.

Bilden Sie sich aus und weiter:

- Unser zukunftsweisender Bachelor-Studiengang Artificial Intelligence and Machine Learning legt seinen Fokus auf die Schlüsseltechnologien der Künstlichen Intelligenz. Hier holen Sie sich das Rüstzeug für die Bereiche Künstliche Intelligenz und Robotik.

- Im CAS Digital Ethics Management lernen Sie, wie Sie mit Wertesystemen und nachhaltigen Handlungen die Digitalisierung vorantreiben. Digitale, KI-basierte und datengesteuerte Lösungen sind die Grundlage für viele Geschäftsmodelle. Das CAS bietet Werkzeuge und Methoden, um diese Lösungen nachhaltiger, sicherer und werteorientierter zu realisieren. Hier sehen Sie dazu ein Info-Video.

- Im CAS Machine Learning geben Sie Ihrer Karriere einen Booster. Mit den richtigen Tools und den technischen Fähigkeiten heben Sie Ihr Niveau auf ein neues Level an. Sie lernen, wie Sie Machine Learning in Ihrer täglichen Arbeit effektiv einsetzen.

Welche Weiterbildung passt? Der Weiterbildungs-Generator verschafft Ihnen den Durchblick.

? Besuchen Sie unsere (Online-)Info-Veranstaltungen!

Gefällt Ihnen unser Informatik-Blog? Hier erhalten Sie Tipps und lesen über Trends aus der Welt der Informatik. Wir bieten Einsichten in unser Departement und bringen Storys über IT-Vordenkerinnen, Visionäre und spannende Menschen: Abonnieren Sie hier unseren Blog.

Neu: Aktuelles aus unserem Departement auf LinkedIn. ? Jetzt folgen!

Keine Downloads vorhanden

Kommentare

26 Kommentare

sc

Ein Protokoll zur Informationsethik: Kritische Entwicklungsschritte, Datenschutz, Einsatz in Behörden und Wissenschaft: https://sensiblochamaeleon.blogspot.com/2023/05/ai-pros-and-cons-informationsethik.html

Roswitha

Ich denke, dem Umgang mit dem Wissen im Internet muss ein gewisser Wissenstransfer vorausgehen, sodass die Präzision all seiner Aussagen durch 0 und 1 repäsentierbar ist. Dadurch sehe ich den Unterschied zwischen AI, analoger Intelligenz und KI, digitale Kompetenz, in den Menschen, die das Medium analog Gott nennen und im Internet durch seine Vorgaben aus 0 übertragbar machen. Natürlich sind darin viele Menschen involviert, sodass ein Netzwerk entsteht, das sich in seinen Strukturen aus der Wirklichkeit ergibt, die mit Hilfe ihrer Übertragungsrate seine Währung übersetzt.

Natürlich intelligent

Nullen und Einsen, also nichts Neues.

S.Büttiker

Die im Blog gemachten Überlegungen sollten m.E. näher zu den Menschen gebracht werden. Ich bin der Überzeugung, dass Digitale Ethik in Zukunft eine wichtige Rolle spielen wird. Wie der Transfer obiger Erkenntnisse und Tatsachen in eine breitere Öffentlichkeit bewerkstelligt werden soll, ist noch zu wenig transparent. Ich spreche dabei weniger von Personen, die sich weiterbilden und naturgemäss interessiert sind, sondern von einer breiteren Bevölkerungsschicht. Dies auch deshalb, weil sich eine umfassende Diskussion über ethische Aspekte aufdrängt und die öffentliche Meinungsbildung angesichts der rasanten Entwicklung eine gwisse Dringlichkeit hat. Ich würde ausserdem anregen, Fragen der digitalen Ethik auch an den Schulen bereits in frühen Jahren vertiefter behandelt wird. Im Rahmen dessen, kann auch das Verständnis für KI und deren Möglichkeiten korrekt verankert werden.

Martin

Ich tue mich schwer mit der Adaption von künstlicher Intelligenz zu erweiterter Intelligenz. Meines Erachtens ist "künstlich" in diesem Kontext schon richtig (gem. Duden: "nicht natürlich, sondern mit chemischen und technischen Mitteln nachgebildet, nach einem natürlichen Vorbild angelegt, gefertigt, geschaffen"), jedoch tue ich mich schwer mit der "Intelligenz". Wie im Blog passend beschrieben, handelt es sich hierbei vielmehr um die Verwendung von bestehendem Wissen. Dies ist m. E. jedoch auch daran geschuldet, dass es einfacher fällt, eine grundlegende, allgemeingültige Definition für "künstlich" zu finden im Gegensatz zu einer Definition von "Intelligenz". Den Vorschlag eines Eids finde ich nicht zielführend, dies da es sich dabei um einen gewissen Idealismus handelt und bei einem Konflikt von idealistischen Sichtweisen, der Idealismus nach "Menschlichkeit über Technik" evtl. nur zweitrangig ist. Um den Kreis des Blogs zu schliessen, auch eine Aufsichtsbehörde wie die IAEA kann internationale Auflagen nicht (problemlos) durchsetzen.

P. Stocker

Interessanter Blog-Beitrag. Es ist auch verständlich, dass Ängste da sind. Die gab es bei jedem grossen Entwicklungsschritt. Was mir aufgefallen ist: Schön wäre es, wenn Algorithmen wirklich mit Rezepten (siehe Video) zu vergleichen wären. Aber wer versteht genau, wie die Algorithmen aufgebaut sind und wie sie funktionieren? Aus meiner Sicht ist es eher eine Blackbox. Man gibt etwas rein (Daten) und dann kommt ein Ergebnis raus. Ich weiss oftmals nicht einmal, wer hinter dem Algorithmus steht... Auf alle Fälle ist Bildung und Sensibilität im Umgang mit KI-Systemen zu fördern. Aus meiner Sicht sollte das bereits in der Primarschule starten. Zum Beispiel: Weniger unnötiges auswendig lernen von Jahreszahlen und Ereignissen, dafür mehr Diskussion darüber, ob die aufgeführten Zahlen und Fakten so Sinn ergeben, wie erkenne ich "Unwahrheiten", etc.

R.Hediger

Ich finde es spannend, dass der KI Gipfel im Bletchleypark stattgefundne hat. Alan Turing würde nicht schlecht staunen, was heute alles möglich ist. Ob der Staat den Fortschritt verhindern oder eingrenzen kann, bezweifle ich. Wenn die EU eine KI Verordnung macht und somit allfällige KI Lösungen verbieten würde, würden diese einfach in anderen Länder angeboten werden. Das Internet kennt ja bekanntlicherweise keine Landesgrenzen. Wo würde man in einer Regulierung eine Grenze ziehen? Bis ein Gesetz erstellt ist (in der Schweiz rechnet man z.B mit 10 Jahren bis ein Gesetz erarbeitet und verabschiedet ist) ist die Technologie bereits viel weiter. Es bedarf hier eher Investitionen in die Bildung aus meiner Sicht.

JS

Ein Moratorium im Bereich der KI durch die Unternehmen sehe ich nicht als zielführend an, die Entwicklung wird dann einfach in anderen geografischen Regionen fortgeführt und wir hinken hinter her. Ganz klar ist, dass es Regulierung braucht. Die Krux liegt aber darin, wie stark man Regulieren möchte. Zu viel und man blockiert die hiesige Forschung/Wirtschaft, zu wenig und man überlasst die Privatsphäre gewinnorientierten Unternehmen.

Michael Sp.

Guter Artikel! Ihren Hinweis auf reale Probleme (im Update vom Dezember 2023) möchte ich gerne aufgreifen. Neben dem von Ihnen beschriebenen Problem bezüglich der Privatsphäre sehe ich aktuell zwei weitere Probleme, die in den letzten Wochen auch in den Medien diskutiert wurden. Zum einen das Thema Urheberrecht (aktuelles Beispiel: «New York Times» verklagt Open AI und Microsoft wegen Urheberrechtsverletzung). Mit welchen Daten werden die Modelle trainiert? Wer hat das Copyright auf diese Daten? Der zweite Aspekt sind Fake-Medien, die man auf den ersten Blick gar nicht auf dem Radar hat. KI kann auch Bilder von illegaler Pornografie produzieren, zum Beispiel von sexuellem Missbrauch von Kindern. Das ist natürlich ein Alptraum sowohl für den Kinderschutz als auch für die Polizei. Auch hier stellt sich die Frage, mit welchem Material die Modelle trainiert wurden.

N. Schmidlin

Vielen Dank für diesen spannenden Beitrag. Werden Rahmenbedingungen festgelegt (Regulierungen etc.), ist das sicher eine Chance, die langjährige Forschung in diesem Bereich weiter voranzutreiben, weil damit auch die Offenheit Neuem gegenüber gefördert werden kann.

Marcel

Ein interessanter Diskussionsansatz zum Begriff "AI/KI", der in meinen Augen leider unverändert am Ziel vorbeischiesst: statt stets von künstlicher, erweiterter usw. «Intelligenz» zu reden, sollte Letztere eher durch etwas Zutreffendes wie z.B. «Algorithmus» oder «maschinelle Routine» ersetzt werden.

Susanne

Vielen Dank für das spannende Interview. Mir gefällt der Gedanke, den «Holberton-Turing-Eid» verbindlich zu machen. Welche Bestrebungen dazu unternimmt die Schweiz?

David Posch

Aus welchem Jahr ist dieser Artikel? KI löst schon seit Jahren Probleme auf kreative Art und Weise und ist bereits schlauer als die meisten Menschen. Die Entwicklung schreitet exponentiell voran. Das sind Tatsachen

Gabriela Bonin

Guten Tag David Posch, danke für Ihren Anstupser. Der Blog-Beitrag bedurfte tatsächlich einer Aktualisierung. Die haben wir jetzt vorgenommen. Beste Grüsse.

Seppi

Nein, der Begriff bleibt aus meiner Sicht weiterhin falsch. Schauen sie einfach, wie man Intelligenz definiert. “Intelligenz ist die Fähigkeit, in einer Umwelt Sinnzusammenhänge und Kausalitäten zu erkennen, zu lernen, Probleme zu lösen und sich durch Einsicht in neuen Situationen zurechtzufinden.” Das kann KI stand heute? Wo?

Hormel

wen es KI geben würde wäre die Weltformel (https://de.wikipedia.org/wiki/Weltformel) schon gefunden

hormel

Alles Richtig, richtige KI hat ihre Programmierung verlasen und das Programm von selber optimiert, In der Endphase Programmiert sich KI (als reine Hardware) von Anfang an selbst So weit sind wir noch lange nicht.

Heide Blay

leider haben in den vergangenen Jahrzehnten die Journalisten aller Medien dafür gesorgt,daß sich der Begriff der künstlichen Intelligenz eingebürgert hat.Statt immer wieder zu behaupten,daß Maschinen denken könnten,sollten sie nun endlich wieder schlicht davon sprechen,daß Maschinen funktionieren...weiter nichts.In der Natur befindet sich der Weltengeist hineingeheimnist. Kein Software-Hersteller hat jedoch bisher behauptet,er könne seinen Kreationen Seele und Geist einhauchen.

Mel

Dankeschön! Wir müssen weg von dem KI-Hype. Dieser Artikel trägt dazu bei! PeopleFirst.TechSecond

A. Frei

Sehr wichtige Thematik, die hoffentlich bald insbesondere in der Ausbildung, aber auch bei Arbeitgebern und in der Politik an Relevanz gewinnt!

Soraya Aminpirooz

Vielen Dank für diesen interessanten Beitrag. Wie kann man eigentlich den digitalen Eid bindend machen? Das wäre ein Schritt in Richtung Einhaltung der digitalen Ethik, was in jetziger Zeit absolut notwendig ist.

Ladan Pooyan-Weihs

@Soraya Aminpirooz, Danke für Ihre Frage. Um den digitalen Eid bindend zu machen, müsste er institutionalisiert werden. Ich stelle mir dazu verschiedene Möglichkeiten vor: Diese Institutionalisierung könnte als eine tiefgreifende, politisch-gesellschaftliche Entscheidung betrachtet werden und somit dem Staat zugeschrieben werden. In diesem Fall würden Informatik-Berufe als staatliche Berufe oder staatlich überwachte Berufe klassifiziert. Demnach müsste die Abschlussprüfung für Informatikerinnen und Informatiker als eine „von staatlichen Prüfungsausschüssen abgenommene Prüfung» für den Eintritt in diesen Beruf definiert werden – so wie es schon heute bei den Juristinnen und Juristen oder Medizinerinnen und Mediziner der Fall ist. Die Institutionalisierung könnte aber auch durch den Gesetzgeber realisiert werden. Somit könnte der Eid unter den Compliance Bestimmungen und Auflagen verankert werden, die jedes Unternehmen in dieser Domaine respektieren und aktiv einhalten müsste. Mit besten Grüssen, Ladan Pooyan-Weihs

R.Hediger

Das wäre eine Möglichkeit mit dem Staatlich kontrollierten Eid. Aber wenn ich die Entwicklung so anschaue, bin ich nicht sicher wie realistisch das dies ist. Eine Software mit algorithmen kann ja jeder der über die notwendigen Skills verfügt entwickeln. Da brauche ich keinen staatlichen Abschluss. Aus meiner Sicht sollte sich der Staat nicht in solche Themen einmischen. Wenn ich sehe, was mit der EU Verordnung über die Cookies angerichtet wurde. Da wurde komplett am Ziel vorbei geschossen. Jetz erscheint bei jeder Webseite ein Overlay oder ein Popup bei welchem 90% der Leute auf "Alles akzeptieren" klicken. Aus meiner Sicht könnte muss das über die Bildung gelöst werden, dass genau klar ist, was mit unseren Daten passiert und wie das Tracking und Profilbildung funktioniert. Für die Algorithmen der KI könnte man ja auch eine Art "Label" definieren welches dem Konsumenten zeigt, dass zu definierende Ethischen Grundsätze eingehalten wurden um die KI zu trainieren resp entwickeln.

M. Imholz

Guter Aspekt, dass es auch viele Programmierer*innen ohne Abschluss gibt. Label könnten helfen, aber wie wir heute greenwashing kennen, wird es sicher auch bei einem Ethik-Label viele Herausforderungen geben. Meiner Meinung nach sind Transparenz und Bildung/Aufklärung sehr essenziell.

Booseh Jafari

Hochinteressantes Artikel. Dieser soll mehr verteilt und von mehr Menschen gelesen werden. Oft haben wir Angst von dem was wir nicht kennen. Die Massen müssen informiert und gebildet werden.

N. Schmidlin

Diesen Gedanken hatte ich beim Lesen dieses Beitrages auch und habe ihn bereits an einige Personen weitergeleitet. In meinem Umfeld begegne ich immer wieder Menschen, die Ängste äussern, ohne sich wirklich mit der Thematik befasst zu haben.

Danke für Ihren Kommentar, wir prüfen dies gerne.